Oggigiorno i sistemi basati sull'Intelligenza Artificiale sono ampiamente utilizzati per prendere decisioni che hanno un impatto di vasta portata sugli individui e sulla società. Le loro decisioni potrebbero interessare tutti, ovunque e in qualsiasi momento, comportando preoccupazioni su potenziali problemi legati ai diritti umani. Pertanto, è necessario andare oltre i tradizionali algoritmi di Intelligenza Artificiale per incorporare principi etici e legali nella loro progettazione e implementazione. In questo articolo ci occuperemo del problema del bias (pregiudizio), di come comprenderlo e affrontarlo.

Introduzione

Gran parte dell'IA, al giorno d'oggi , è alimentata da big data e potenti algoritmi di apprendimento automatico. Gli algoritmi di Intelligenza Artificiale sono ampiamente utilizzati da aziende, governi e altre organizzazioni per prendere decisioni che hanno un impatto notevole sugli individui e sulla società. Tali decisioni offrono soluzioni ai problemi affrontati nelle diverse discipline o nella vita quotidiana, ma allo stesso tempo comportano dei rischi. L'impatto discriminatorio dell'Intelligenza Artificiale nei processi decisionali rispetto a determinati gruppi di popolazione è già stato osservato in una varietà di casi. Ad esempio, è stato riscontrato che lo strumento di annunci di Google per la pubblicità mirata, offre un numero significativamente inferiore di annunci per lavori ben pagati alle donne rispetto che agli uomini (gender bias). Il pregiudizio è vecchio quanto il mondo ed è la natura umana che spinge i membri della maggioranza dominante ad ignorare le esperienze di altri gruppi minoritari. Tuttavia, il processo decisionale basato sull'Intelligenza Artificiale può amplificare i pregiudizi preesistenti o, peggio ancora, portare a nuovi tipi di pregiudizi. Tali eventualità in costante aumento hanno portato a una riconsiderazione dei sistemi basati sull'Intelligenza Artificiale verso nuovi approcci che tengano conto dell'equità nel prendere le decisioni.

In questo articolo affronteremo il problema da 3 punti di vista:

- Comprendere il bias - Approcci che aiutano a capire come il bias si crea nella società ed entra nei nostri sistemi socio-tecnici, si manifesta nei dati utilizzati dagli algoritmi di Intelligenza Artificiale e può essere modellato e definito formalmente.

- Mitigare il bias - Approcci che affrontano il bias nelle diverse fasi del processo decisionale dell'IA, vale a dire, pre-elaborazione, elaborazione, e metodi di post-elaborazione incentrati rispettivamente su input di dati, algoritmi di apprendimento e output di modelli.

- Tener conto del bias - Approcci che tengono conto del bias in modo proattivo, tramite la raccolta dati consapevole, o retroattivamente, rendendo umanamente comprensibili le decisioni prese dall'IA.

Comprendere il bias

Consideriamo il bias (pregiudizio) come l'inclinazione di una decisione presa da un sistema di IA che è per o contro una persona o un gruppo, soprattutto in un modo considerato ingiusto. Data questa definizione, ci concentriamo su come il bias entri nei sistemi di IA e come si manifesti nei dati che compongono l'input degli algoritmi di IA.

Cause socio-tecniche

L'Intelligenza Artificiale viene addestrata sui dati generati dagli esseri umani o raccolti tramite i sistemi creati da essere umani. Pertanto, qualunque pregiudizio esista negli esseri umani entra nei sistemi e, peggio ancora, viene amplificato a causa di sistemi socio-tecnici complessi, come il web (Figura 1). Di conseguenza, gli algoritmi possono riprodurre (o addirittura aumentare) esistenti disuguaglianze o discriminazioni.

Figura 1: L'immagine del profilo Twitter del chatbot Tay. Entro 16 ore dal suo rilascio, Microsoft dovette sospendere l'account a causa del comportamento razzista appreso dal bot

Ad esempio, il rischio di un addestramento improprio è particolarmente elevato per i chatbot. Il chatbot AI basato su Twitter di Microsoft, chiamato Tay, nonostante fosse stato sottoposto a stress test "in una varietà di condizioni", apprese un comportamento antisemita e razzista a causa degli sforzi di un gruppo specifico di individui. Questi individui esposero Tay ripetutamente a contenuti discriminatori, facendole acquisire numerosi pregiudizi discriminatori. Mentre molti algoritmi ML smettono di apprendere dopo aver completato il loro addestramento iniziale, alcuni chatbot continuano ad apprendere, e questi chatbot tendono ad essere particolarmente veloci nell'acquisire nuovi pregiudizi. La natura dei social media implica che questi chatbot possono essere frequentemente esposti a input discriminatori e se i dati forniti in addestramento per rifiutare o contrastare questi input, fossero insufficienti, queste implementazioni ML possono facilmente apprendere pregiudizi simili a quelli umani. Un altro esempio sono le ricerche sull'elaborazione del linguaggio naturale (PNL) che utilizzano frequentemente modelli linguistici. Questi consumano grandi quantità di testo del web per fornire la conoscenza di base ai sistemi di PNL su come funziona la lingua. Come vantaggio, i sistemi iniziano con una grande comprensione e, con una piccola quantità di dati di addestramento, possono produrre risultati eccellenti. Ciò che si paga, però, è che i pregiudizi sociali si diffondono attraverso il corpus di pre-addestramento. Un esempio è la tendenza ad associare ai nomi europei opinioni positive e ai nomi africani opinioni negative.

Come si manifesta

Il bias può manifestarsi nei dati attraverso features sensibili e le loro influenze causali, o attraverso la sotto/sovrarappresentazione di alcuni gruppi.

Features sensibili e influenze causali - I dati codificano una serie di caratteristiche delle persone sotto forma di valori di features. Features sensibili che identificano i motivi di discriminazione o pregiudizio possono essere presenti o meno. Rimuovere o ignorare tali features sensibili non impedisce l'apprendimento di modelli con bias, perché altre features correlate potrebbero essere utilizzate al loro posto. Ad esempio, i quartieri nelle città degli Stati Uniti sono altamente correlati al fattore razziale e questo fatto è stato utilizzato sistematicamente come motivazione nel non accogliere la richiesta di un prestito bancario. Al contrario, includere features sensibili nei dati può essere benefico nella progettazione di modelli paritari. Le features sensibili possono anche essere correlate con la caratteristica di destinazione che i modelli di classificazione vogliono prevedere. Ad esempio, la preferenza della minoranza "A" per le auto rosse potrebbe indurre pregiudizi contro tale minoranza nella previsione del tasso di incidenti. Infatti, se le auto rosse fossero le preferite anche dai cattivi guidatori, un premio assicurativo più alto potrebbe essere fissato per i proprietari di auto rosse, il che avrebbe un impatto sproporzionato sui membri della minoranza "A". La semplice correlazione tra caratteristiche apparentemente neutre può quindi portare a decisioni discriminatorie. Scoprire e capire le influenze causali tra le variabili è uno strumento fondamentale per affrontare il bias.

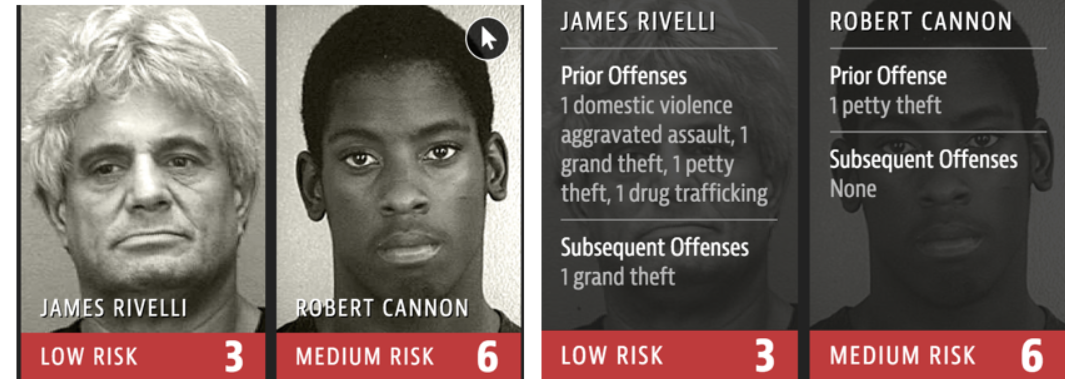

Rappresentatività dei dati - Le inferenze statistiche (incluso il ML) richiedono che i dati da cui è stato appreso il modello siano rappresentativi dei dati su cui si applica. Tuttavia, la raccolta dei dati spesso soffre di pregiudizi che portano alla sovra o sottorappresentazione di alcuni gruppi, soprattutto nei big data, dove molti set di dati non sono stati creati con il rigore di uno studio statistico, ma sono il sottoprodotto di altre attività con obiettivi diversi. Se i gruppi mal rappresentati coincidono con gruppi sociali verso i quali esistono già pregiudizi sociali o discriminazione, anche i processi computazionali imparziali possono portare a procedure decisionali discriminatorie. La rappresentazione errata dei dati può portare a circoli viziosi che perpetuano discriminazione e svantaggio (Figura 2).

Figura 2: COMPAS è un esempio comunemente citato di pregiudizio razziale appreso. Si tratta di una implementazione ML utilizzata per prevedere il rischio di recidiva nei criminali condannati. COMPAS ha spesso dimostrato un pregiudizio razziale simile a quello umano, prevedendo erroneamente un rischio di recidiva per gli imputati neri quasi il doppio di quello per gli imputati bianchi con una storia giudiziaria simile o peggiore

Un esempio è quello di un'azienda che assume principalmente gente dagli Stati Uniti; essa può avere un certo grado di comprensione della qualità universitaria negli Stati Uniti, ma fallisce nel riconoscere i candidati provenienti da prestigiose università straniere per mancanza di dati.

ATTENZIONE: quello che hai appena letto è solo un estratto, l'Articolo Tecnico completo è composto da ben 2246 parole ed è riservato agli ABBONATI. Con l'Abbonamento avrai anche accesso a tutti gli altri Articoli Tecnici che potrai leggere in formato PDF per un anno. ABBONATI ORA, è semplice e sicuro.