L’articolo tratta la teoria dei sensori di immagine soffermandosi sui sensori CMOS, confrontandoli con i sensori CCD. Vengono descritti i principali parametri che determinano la scelta di un sensore per una determinata applicazione aiutando l’utilizzatore ad effettuare la scelta più indicata.

Al giorno d’oggi applicazioni come la fotografia o il video digitale, la video sorveglianza, l’ispezione ottica del processo produttivo e svariate applicazioni nel settore automotive dedicate alla sicurezza e all’assistenza alla guida si stanno sempre più diffondendo. Il cuore di tutte queste applicazioni è il sensore d’immagine, che rappresenta il punto focale intorno al quale costruire il progetto.

Il sensore d’immagine

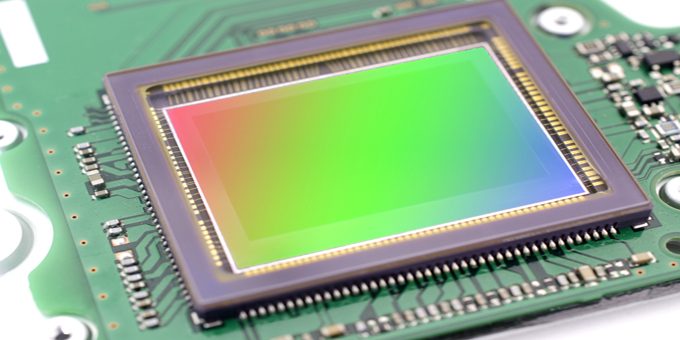

Per sensore d’immagine si intende il trasduttore che converte l’immagine ottica in una sua rappresentazione o codifica elettrica, si tratta essenzialmente di un chip di silicio in grado di catturare e misurare la luce, ovvero la quantità di fotoni che lo raggiungono. Il sensore ha generalmente forma rettangolare e dimensioni tipicamente contenute, variabili da costruttore a costruttore e da modello a modello. Un esempio di sensore d’immagine CMOS è visibile in figura 1.

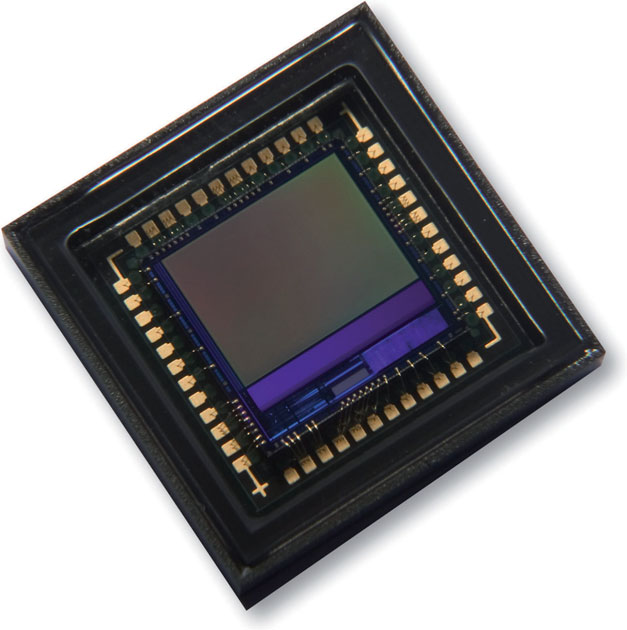

Figura 1: sensore d’immagine CMOS (fonte www.micron.com).

La superficie del sensore è formata da milioni di minuscoli ricevitori disposti secondo una griglia regolare. Questi ricevitori chiamati anche photosites sono in effetti i microsensori che effettuano la conversione da fotoni in elettroni. Ogni singolo ricevitore sarà in grado di fornire in uscita una carica elettrica proporzionale alla quantità di fotoni che lo hanno colpito; la carica viene poi convertita da un apposito circuito di conversione analogico-digitale in un valore numerico. L’insieme dei valori ottenuti viene elaborato dal microprocessore che comanda l’acquisizione e costituisce l’informazione necessaria alla ricostruzione dell’immagine catturata. Ognuno dei valori ottenuti dai photosites costituirà un pixel dell’immagine ottenuta.

Figura 2: miscelazione additiva dei colori nel sistema RGB.

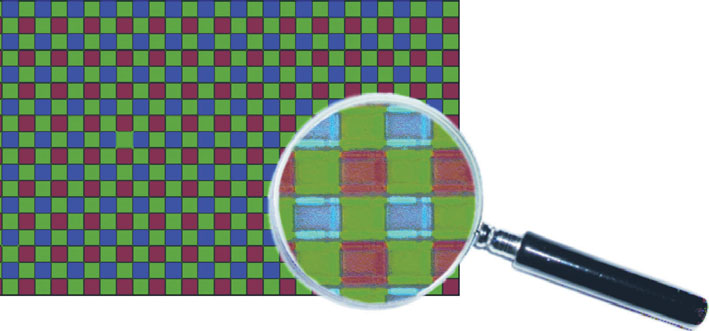

Figura 3: Bayer Pattern e zoom reale con ingrandimento fino a 10um.

Sensori CCD e sensori CMOS

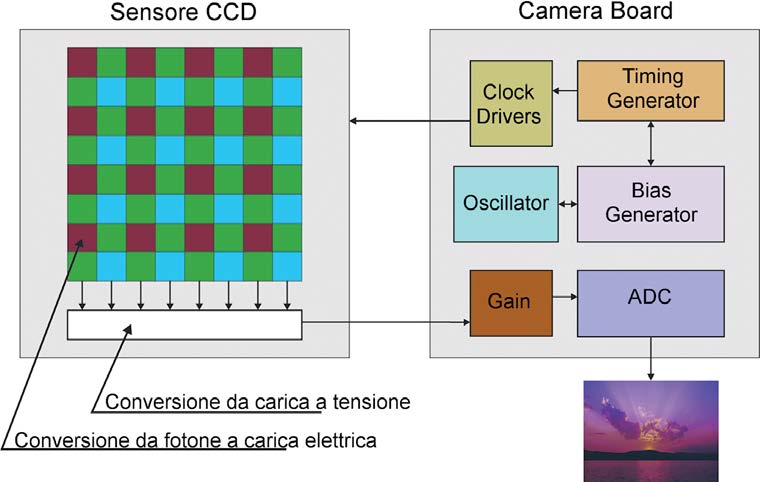

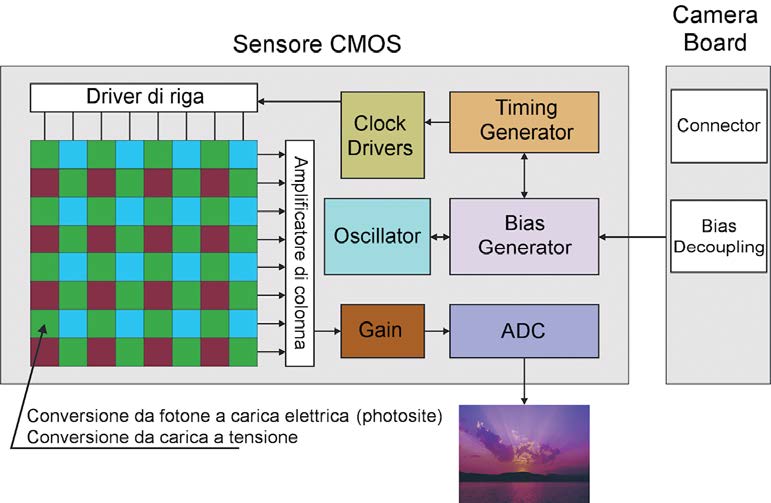

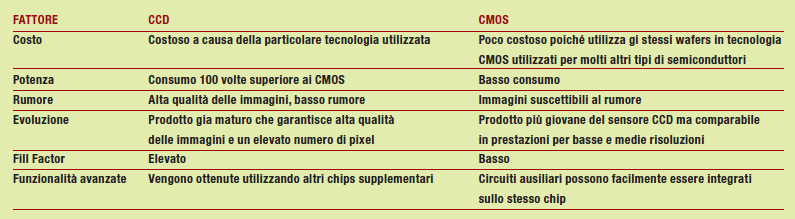

Attualmente ci sono due tipi di sensori d’immagine in commercio, i CCD (Charge Coupled Device) ed i CMOS (Complementary Metal Oxide Semiconductor); i primi sensori disponibili nascevano con la tecnologia CCD e per alcune applicazioni questa tipologia è ancora attualmente utilizzata. Negli ultimi anni l’avvento dei sensori CMOS ha rivoluzionato notevolmente il mercato a favore di questi ultimi soppiantando i sensori CCD in molte applicazioni. Entrambi si basano sul concetto di convertire la carica di ogni photosites in un formato digitale mediante un ADC (Analog to Digital Converter) ma differiscono per come le informazioni vengono processate. Per i sensori CCD l’informazione sulla carica viene prelevata dai photosites riga per riga e memorizzata in un registro il cui contenuto viene passato ad un amplificatore e successivamente al convertitore ADC. Dopo che la riga è stata interamente processata viene eliminata dal registro d’uscita e viene caricata la riga successiva che subisce lo stesso trattamento. Nei sensori CMOS grazie alla tecnologia che permette di ridurre costi e dimensioni insieme al photosites è stata integrata anche una serie di transistor che realizzano una amplificazione e conversione della carica in tensione. Attraverso una struttura matriciale è possibile selezionare singolarmente ogni photosites attraverso l’indirizzo di riga e colonna e inviare la tensione ad un ADC che esegue la conversione finale. Poiché ogni ricevitore di un sensore CMOS ha accanto a sè dei circuiti che “rubano” un po’ di spazio, il sensore risulta in generale meno sensibile alla luce di un analogo CCD, in quanto una parte dei fotoni colpirà i circuiti ausiliari anziché la parte del fotosito sensibile alla luce. La percentuale dell’area di un fotosito che risulta utile per raccogliere la luce viene detta fill factor (fattore di riempimento). Un sensore CCD ha un fill factor del 100%, un sensore CMOS molto meno. In condizioni di luce scarsa un sensore CMOS necessita di maggiori aperture o di tempi di esposizione leggermente più lunghi di un sensore CCD. Per ovviare in parte a questo problema, vengono spesso utilizzate sopra ogni singolo photosite delle micro-lenti, che intercettano la luce destinata a cadere sulla circuiteria ausiliaria e la convogliano sulle parti sensibili. L’obbiettivo dei costruttori è di aumentare il fill factor dei sensori CMOS riducendo sempre di più le dimensioni dei circuiti integrati.

Figura 4: diversi tempi di esposizione nello stesso frame.

Pregi e difetti dei sensori CMOS

Analizziamo ora in dettaglio i benefici e gli svantaggi dei sensori CMOS. I sensori CMOS sono più economici da produrre dei sensori CCD. Essi utilizzano infatti la stessa collaudata tecnologia produttiva dei normali microprocessori e dei chip di memoria, non richiedendo processi produttivi distinti il costo fisso degli impianti può essere suddiviso su una maggiore varietà di prodotti. Poiché la struttura dei sensori CMOS è la stessa dei normali microprocessori, è facile integrare i circuiti accessori direttamente sul chip del sensore e ad ogni innovazione produttiva i vantaggi sono immediatamente applicabili anche a questa tipologia di prodotti. Inoltre in questo modo si ottengono dispositivi sempre più compatti integrando quanto più possibile l’elettronica di controllo direttamente nel chip come evidenziato dal confronto fra figura 5 e figura 6.

Figura 5: struttura delle fotocamere digitali con sensore CCD

Figura 6: struttura delle fotocamere digitali con sensore CMOS

Un sensore CMOS standard soffre del cosiddetto “rumore”: la carica elettrica di ogni singolo photosite viene trasportata via durante la lettura da circuiti di trasporto e amplificazione, lievi alterazioni del segnale dovute a microscopiche imperfezioni nei circuiti formano una sorta di “disturbo” sull’immagine. Tale disturbo si può manifestare diversamente da chip a chip, nei sensori CMOS più moderni speciali circuiti filtro addizionali cancellano il “rumore” basandosi su una sua misurazione effettuata in fabbrica. Ogni chip CMOS ha infatti il proprio “schema” di rumore. Queste operazioni di filtraggio però influiscono sulla rapidità di estrazione dell’informazione. In generale quindi è possibile affermare che i sensori CMOS sono più sensibili alle interferenze e quindi producono un immagine qualitativamente inferiore rispetto ai sensori CCD, anche se questo era molto più vero nel passato ed era la motivazione principale per cui la principale applicazioni dei sensori CMOS erano quelle basate sul basso costo, dove la qualità non era importante. Oggi la tecnologia CMOS applicata all’immagine ha fatto molti progressi, tanto che anche nel campo della fotografia diverse fotocamere digitali di fascia alta utilizzano un sensore CMOS corredato da filtri anti-rumore con risultati eccellenti. Un altro considerevole vantaggio dei sensori CMOS è il consumo di corrente, infatti rispetto ai CCD questo aspetto si riduce di un fattore 100 rendendo quindi indispensabile l’utilizzo dei sensori CMOS in dispositivi portatili a batteria come i telefoni cellulari, i laptop ed i lettori di codici a barre. Questo accade perché i sensori CCD sono essenzialmente sensori di tipo capacitivo che necessitano di più tensioni di alimentazione ricavate internamente al chip, al contrario dei sensori CMOS che utilizzano una unica alimentazione tipicamente a 3.3V. se quindi un sensore CCD richiede dai 2 a 5 watt per i segnali digitali in uscita un sensore CMOS va dai 20 ai 50 milliwatt per lo stesso pixel throughput.

Tabella 1: Confronto tra sensori CCD e sensori CMOS.

Tabella 2: formati ottici dei sensori.

Bianco e nero o colore?

A questo punto viene normale chiedersi dove nel sensore d’immagine venga immagazzinata l’informazione sul colore. il sensore CMOS converte l’intensità luminosa (il numero di fotoni che lo colpiscono in una determinata unità di tempo) in una carica elettrica ad essa proporzionale. Il sensore è assolutamente indifferente alla lunghezza d’onda di tali fotoni, ovvero a ciò che la vista umana interpreta come colore, ma si limita a considerarne il numero. Questo significa che il sensore è cieco ai colori, e registra tutto in bianco e nero. Questo può essere sufficiente o addirittura un vantaggio per chi necessita solamente di questo tipo di informazione come per esempio i lettori di codici a barre ma non lo è di sicuro per chi vuole utilizzare il sensore per scattare una bella foto o realizzare un video. Se si pensa al modello RGB ogni immagine può infatti essere scomposta, attraverso filtri o altre tecniche, in tre immagini composte da tre colori base il rosso, il verde e il blu. Più specificamente i 3 colori principali corrispondo a forme d’onda (radiazioni luminose) di periodo fissato. A una lunghezza d’onda di 700 nm corrisponde il rosso, a 546.1nm il verde, a 435.8 nm il blu. L’RGB è un modello additivo: unendo i tre colori con la loro intensità massima si ottiene il bianco (tutta la luce viene riflessa). La combinazione delle coppie di colori dà il ciano, il magenta e il giallo. Per applicare il modello RGB ed ottenere un immagine colorata è chiaro che dovremmo avere non uno, ma tre sensori diversi per registrare l’informazione minima che ci possa consentire di ricostruire i colori: uno sensibile al rosso, uno al verde e uno al blu. Ovviamente è una strada difficilmente praticabile anche se non impossibile ma che farebbe esplodere i costi. Quello che si fa è accettare un compromesso naturalmente sacrificando la qualità dell’immagine, una parte dei photosites viene dedicato alla registrazione di un solo colore fondamentale. Normalmente in un sensore il 25% dei photosites registra il rosso, il 25% il blu e il 50% registra il verde. Il motivo per la preferenza sul verde è che anche l’occhio umano risulta in effetti più sensibile a questo colore fondamentale rispetto agli altri due. Per rendere sensibili ad una particolare lunghezza d’onda i photosites, davanti ad essi viene posto un filtro che lasci passare solo le lunghezze d’onda volute. Questi filtri vengono disposti secondo uno speciale schema (in inglese pattern) a scacchiera. Il più utilizzato è il cosiddetto Bayer pattern. Poiché l’obbiettivo è ottenere un pixel di immagine per ogni photosite abbiamo ora un problema. Infatti con l’applicazione del filtro Bayer abbiamo solo un terzo delle informazioni necessarie alla definizione esatta del colore, ovvero solo uno dei tre colori primari. I dati mancanti vengono calcolati per interpolazione ossia sono dedotti da un algoritmo di calcolo più o meno complesso, che prende in considerazione i valori registrati dai pixel adiacenti per effettuare una stima. Naturalmente il processo introduce un errore poiché si cerca di stimare dei valori che si è scelto di non registrare. Il risultato è nella maggior parte dei casi piuttosto soddisfacente, La risoluzione reale dell’immagine ottenuta è inferiore a quella dichiarata per il sensore e viene raggiunta solo grazie all’interpolazione. In situazioni particolari i limiti del procedimento saltano fuori, per esempio, si introduce un certo livello di sfocatura dell’immagine necessario per evitare artefatti di colore che si verificano comunque su superfici a mosaico (es. una camicia).

Risoluzione e formati

La risoluzione di un sensore è rappresentata dal numero di photosites che risultano utilizzabili per ottenere un’immagine, infatti tipicamente oltre a quelli effettivamente letti per ottenere l’immagine ne esistono di aggiuntivi che servono per calcoli interni al sensore al fine di sottrarre il rumore elettrico generato dall’elettronica aggiuntiva del photosite. La risoluzione è abitualmente espressa in Megapixel ed è calcolabile anche come prodotto della massima risoluzione verticale per la massima risoluzione orizzontale, ossia se il sensore è composto da 1280 colonne e 1024 righe si ha 1280x1024=1,3Mp. Una cosa molto importante da sottolineare è che un aumento della risoluzione non è sinonimo di un aumento di qualità dell’immagine. Avere un maggior numero di megapixel a disposizione sicuramente ha come effetto un aumento della nitidezza ma non necessariamente della definizione dell’immagine, poiché se ci interessa notare un particolare o stampare la foto più che i megapixel ci interessa la risoluzione orizzontale (o verticale) e passando da sensore all’altro quello che conta è la radice quadrata del rapporto tra le dimensioni dei sensori in Mp. I formati più diffusi per i sensori d’immagine CMOS sono ovviamente quelli imposti dal mercato per la maggioranza di applicazioni video, ossia:

➤ Quarter Common Intermediate Format (QCIF) 176 x 144 (25,300 pixels);

➤ Quarter Video Graphics Array (QVGA) 320 x 240 (76,800 pixels);

➤ Common Intermediate Format (CIF) 352 x 288 (101,400 pixels);

➤ Video Graphics Array (VGA) 640 x 480 (307,200 pixels);

➤ Super Video Graphics Array (SVGA), una serie di dimensioni standard: 800 x 600 (480,000 pixels); 1024 x 768 (786,400 pixels) (oppure Extended Graphics Array (XGA)); e ancora 1280 x 1024 (1.3-megapixel) 1600 x 1200 (2-megapixel). I sensori a risoluzioni più elevate da 2048 x 2048 (4-megapixel) fino a 4096 x 4096 (16-megapixel) sono tipicamente dedicati al settore della fotografia digitale per l’impiego nelle fotocamere. Il formato ottico è un parametro relativo al sensore, ottenuto misurando la diagonale in millimetri e moltiplicandola per 16 ed esprimendo il tutto in pollici. Questa formula è il risultato di diversi fattori storici tra i quali la dimensione delle lenti progettate per le pellicole delle macchine fotografiche.

Global shutter o Rolling shutter

Un parametro importante da considerare per la scelta del sensore d’immagine più adeguato ad una applicazione è la modalità di esposizione. Le metodologie sono essenzialmente due il rolling shutter o il global shutter. Tutti i sensori CCD usano il global shutter i sensori CMOS possono usare entrambe le metodologie ma praticamente la maggior parte dei prodotti sul mercato usano la tecnologia rolling shutter. Prima però e necessario definire cos’è un frame, un frame non è altro che l’insieme delle letture dei vari photosites dall’inizio alla fine della superficie utile del sensore, rappresenta quindi il contenuto informativo utile a comporre l’immagine. I sensori global shutter espongono tutti i pixel simultaneamente. I vari photosites cominciano a catturare i fotoni finché non termina il tempo di esposizione impostato (o shutter time). Dopodiché avviene il readout dei valori di carica immagazzinati e la conversione prima in tensione e poi in un numero in formato digitale. Tutto ciò avviene con un meccanismo a tempo senza alcun otturatore fisico che eviti il passaggio della luce. Un sensore rolling shutter è molto diverso, l’esposizione “rotolante” espone le porzioni diverse del frame in istanti temporali distinti, scorrendo o rotolando che dir si voglia su tutta la superficie del sensore. Anche in questo caso non c’è niente di fisico che decide quale parte del frame è esposta e quale invece è nascosta ma avviene tutto per suddivisione di tempo esponendo ogni parte del frame per un tempo pari almeno al tempo di esposizione. La maggior parte dei sensori durante il readout di un blocco di pixel espone i blocchi successivi per massimizzare il troughput. Ovviamente il meccanismo del rolling shutter può rivelarsi pericoloso se l’illuminazione dell’ambiente varia durante l’esposizione di un frame, poiché solo una parte potrebbe risultare correttamente esposta. Un esempio classico può essere quello che viene definito flicker noise legato ad una fonte di illuminazione artificiale. Come sappiamo la lampadina classica è alimentata con una tensione alternata con frequenza di 50/60 Hz, in questa situazione il flicker noise si manifesta intorno ai 100/120 Hz, se il readout del frame avviene con una frequenza inferiore a questa si possono avere differenze di esposizione tra i vari pixel dell’immagine.