I sistemi embedded stanno ora facendo un uso più massiccio delle tecnologie di elaborazione delle immagini digitali per aumentare la produttività, incrementare le prestazioni e migliorare la qualità della vita nel suo complesso. Vediamo in che modo.

I sistemi di visione intelligenti costituiscono uno sviluppo relativamente nuovo; forniscono una connessione tra il dominio talvolta freddo e intransigente della tecnologia moderna, e il mondo in cui tutti viviamo, più vago, variabile e in ultima analisi più volatile. Colmare questo divario è ora necessario dato che ci basiamo così pesantemente sulla tecnologia. Attraverso la loro introduzione e la loro diffusa adozione, tutti i tipi di sistemi saranno meglio equipaggiati per “comprendere” il mondo reale e di conseguenza per adattarvisi meglio. La capacità di acquisire e di interpretare gli oggetti di tutti i giorni “in un contesto” rimuove molte barriere che si formano quando si usa la tecnologia in ausilio alla vita moderna, tuttavia, sono significative le sfide intrinseche che occorre affrontare per mettere in grado i sistemi embedded di identificare in modo accurato gli oggetti attraverso la cattura delle immagini. D’altro canto, i sensori di immagine hanno subito una straordinaria evoluzione negli ultimi anni e non è un’esagerazione affermare che i sistemi di visione stanno realmente diventando più intelligenti, combinando questi ultimi ai potenti sistemi di elaborazione sui quali girano algoritmi avanzati.

CASI DI UTILIZZO IN EVOLUZIONE ED EMERGENTI

I casi di utilizzo per la Visione Intelligente si stanno espandendo, trainando l’innovazione da parte degli OEM desiderosi di offrire la soluzione giusta in ciascun caso. Forse, il caso di utilizzo con il profilo più alto è la sorveglianza per la sicurezza; le giornate di monitoraggio umano (che porteranno con sé sempre il rischio di errori causati dalla stanchezza dell’osservatore) potrebbero a ragione essere contate, dato che i sistemi embedded possono ora “apprendere” come identificare oggetti sospetti e schemi in mezzo a moltitudini di oggetti, anche fino al punto di identificare un singolo oggetto di interesse e di sorvegliare questi in più punti monitorati. Altre applicazioni esistenti che traggono vantaggio dai progressi nella tecnologia includono l’automazione industriale, o “Industry 4.0” come è talvolta conosciuta.

Quest’ultima rende possibile l’automazione intelligente fornendo un maggiore supporto all’operatore, il che porta a sua volta ad una maggiore produttività. L’ispezione automatica delle merci è un esempio in cui i sistemi di visione stanno ora prendendo decisioni che un tempo erano di competenza di un operatore. Le applicazioni emergenti includono i Sistemi Avanzati di Guida Assistita (ADAS, acronimo di Advanced Driver Assistance Systems), i quali impiegano più videocamere per fornire una “visione d’insieme” per i conducenti, oltre agli avvisi di collisione e di allontanamento dalla corsia. Per questi tipi di innovazioni, è prassi comune all’interno del settore automotive iniziare con i modelli di alta fascia, per migrare rapidamente verso le utilitarie, dato che il costo di adozione crolla con l’adozione in grossi volumi.

Oltre agli ADAS, che possono essere adottati ampiamente, esistono aree di applicazione che potrebbero avere bacini d’utenza persino più vasti, come i sistemi di visione per modificare il modo in cui comunichiamo ed il modo in cui le cure mediche vengono applicate. Entrambe queste aree sono caratterizzate da una collaborazione sempre più stretta tra le persone e la tecnologia, e come tali dovrebbero anche trarre vantaggio nel prossimo futuro dai sistemi di visione più intelligenti. Per esempio, i chirurghi si basano già sulle videocamere per trasmettere informazioni dall’interno del corpo di un paziente quando stanno effettuando un intervento chirurgico in artroscopia; con il progresso dei sistemi di visione artificiale più intelligenti potrebbe essere possibile per il chirurgo operare da remoto quando porta avanti una simile procedura, o persino sarebbe possibile per la macchina diventare essa stessa il “chirurgo”.

Figura 1.

SUPPORTO ALL’INDUSTRIA

La connettività internet ha influenzato il modo in cui le videocamere - ed in particolare le videocamere per la sicurezza nei sistemi a circuito chiuso - si sono evolute nel corso degli ultimi anni. È ora possibile visualizzare e controllare una videocamera da remoto attraverso una connessione internet (sicura), consentendo all’osservatore di mettere a fuoco ed inclinare una videocamera, o ingrandire o rimpicciolire una scena. Tuttavia, l'intelligenza in questo scenario è ancora saldamente nella testa dell’operatore. I sistemi di visione più intelligenti aggiungono una nuova dimensione, come risulta evidente dalla formazione di un’associazione industriale dedicata a promuovere questo nuovo paradigma; l’Embedded Vision Alliance (www.embedded-vision.com), la quale punta a fornire una connessione tra la vasta quantità di ricerche disponibili sulla visione computerizzata e lo sviluppo di sistemi dedicati reali che mettono in pratica i risultati di tali ricerche.

In passato, le soluzioni di visione si sono grandemente basate sulla qualità dell’ottica della videocamera per fornire visori video di qualità superiore. In un sistema di visione più intelligente, un’elaborazione potente ovvierà in larga misura alla necessità di videocamere costose e di lenti ottiche necessarie nei sistemi essenzialmente analogici di oggi, sostituendole con videocamere digitali a basso costo che forniscono alti livelli di dati di immagini grezze, i quali possono essere successivamente elaborati da processori dedicati veloci ed efficienti sui quali girano algoritmi avanzati. Molti di questi algoritmi sono ora in fase di sviluppo in modo collaborativo per creare risorse come la Libreria OpenCV (www.opencv.org), che offre oltre 2.500 algoritmi scritti in C, C++, Java e Phyton, i quali spaziano in complessità dalle funzioni semplici come i filtri di immagini sino alle funzioni più avanzate per l’analisi, come la rilevazione del movimento. Lo spostamento del paradigma dai sistemi di visione analogica ad alto costo alle soluzioni interamente digitali a basso costo consentirà di adottare più videocamere in più aree applicative, tutte basate prevalentemente sui processori e sugli algoritmi sviluppati dagli OEM e supportate dagli sforzi industriali quali l’Embedded Vision Alliance e l’OpenCV Library. Al cuore di questa evoluzione della visione, c’è l’abilità di integrare in modo efficiente, per i costi e per i consumi, quantità immense di risorse di elaborazione digitale dei segnali (DSP) di elaborazione con funzione generica e il supporto alla proprietà intellettuale sintetizzata/sintetizzabile in una singola piattaforma flessibile su silicio.

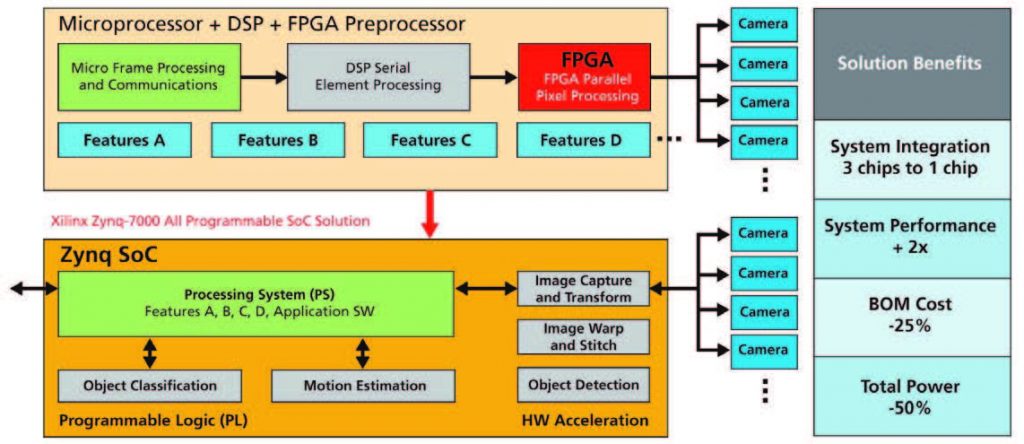

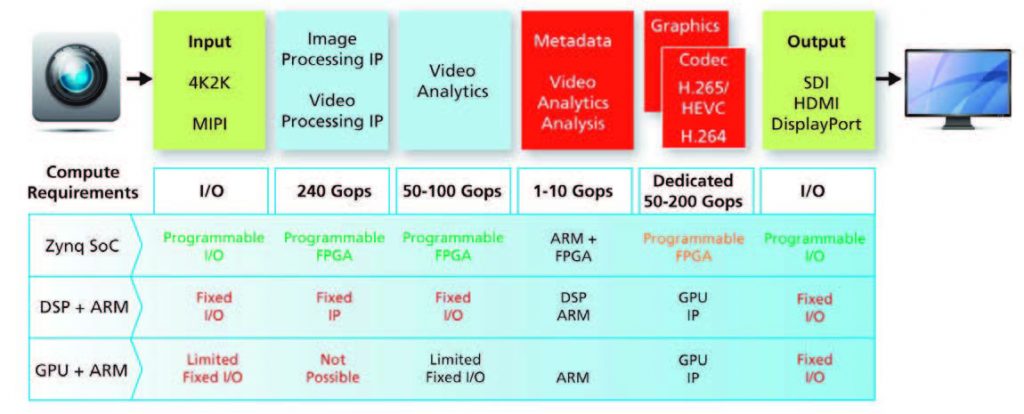

Figura 2.

SVILUPPO RAPIDO

Come discusso in precedenza, i sistemi di visione più intelligenti assumeranno molte forme, e mentre i blocchi fondamentali rimarranno gli stessi - DSP, processori embedded e proprietà intellettuale di supporto - ci sarà la necessità di “regolare” ciascuna soluzione per l'area applicativa specifica. Lo sviluppo delle soluzioni su misura a partire da servizi discreti è naturalmente possibile, ma allo scopo di supportare l’adozione in grossi volumi, una soluzione su chip singolo, o System on-a-Chip (SoC) costituisce la strada più conveniente verso il mercato, come oggi evidenziato in molti settori, e più nello specifico nel settore consumer. Tuttavia, sviluppare un SoC risulta ancora costoso e complesso, e spesso è fattibile solo se ci si rivolge ad una singola applicazione in volumi molto grossi (come i dispositivi consumer portatili). La creazione di un SoC che soddisfi le necessità di molti sistemi intelligenti di visione potrebbe essere difficoltosa e necessiterà di una certa misura di ridondanza nel progetto. L’uso di una piattaforma programmabile, tuttavia, ovvia a questo problema.

Il SoC interamente programmabile Zynq®-7000 integra un sottosistema di elaborazione ARM® Cortex™-A9 Dual- Core leader di mercato accanto alla matrice FPGA ad alte prestazioni di Xilinx, e ciò consente di adattarlo rapidamente alle necessità di vari sistemi di visione intelligenti. Ad esempio, la Figura 1 mostra come un SoC Zynq si confronta con un’architettura multichip in un’applicazione ADAS, la quale usa più videocamere, per fornire funzionalità tra cui la rilevazione dei punti ciechi, l’avviso di scostamento dalla corsia, la rilevazione di pedoni ed una vista a 360 gradi dell’auto in fase di parcheggio. La Figura 2 evidenzia un flusso di segnale generico per un sistema di visione intelligente e confronta il dispositivo Zynq con un SoC che integra core DSP e GPU (unità di processore grafico), e illustra come il sottosistema di elaborazione e la logica FPGA possono lavorare assieme per fornire una piattaforma più flessibile e versatile. L’estensibilità del SoC Zynq, usando la logica FPGA, assicura anche la protezione contro l’eventualità di raggiungere un “tetto” di prestazioni se è richiesta potenza di calcolo aggiuntiva.

CONCLUSIONE

Il successo dei sistemi di visione più intelligenti si baserà pesantemente sugli sviluppatori di soluzioni embedded che possiedono le tecnologie giuste per soddisfare i requisiti in termini di prestazioni e di flessibilità, qualcosa che l’industria apprezza e sta lavorando duramente per ottenere. In supporto a questo, Xilinx ha anche stretto collaborazioni con pionieri nella progettazione a livello di sistema, fra cui MathWorks e National Instruments, per accelerare la progettazione. MathWorks ha rilasciato di recente un nuovo flusso di lavoro guidato per i SoC interamente programmabili Zynq- 7000 con la sua versione R2013b, la quale consente ai progettisti di creare e di modellizzare i propri algoritmi in MATLAB e Simulink, di partizionare i propri progetti tra hardware e software e di finalizzare, integrare, collaudare e verificare tali modelli sulle piattaforme di progettazione mirate di Xilinx.

Analogamente, gli ingegneri possono astrarre la complessità della progettazione RTL tradizionale usando l’ambiente di programmazione grafica di National Instruments, in combinazione con la sua piattaforma hardware riconfigurabile I/O (RIO), la quale usa i SoC interamente programmabili di Xilinx. L’uso di una piattaforma programmabile come i SoC interamente programmabili Zynq-7000, supportata da tool di punta, da una serie di strumenti di progettazione dedicata e da soluzioni open source come OpenCV Library, il tutto supportato dagli sforzi dell’Embedded Vision Alliance, contribuirà a fare sì che gli sviluppatori abbiano accesso alle migliori risorse disponibili per raggiungere i propri obiettivi di progetto. Ad esempio, in qualità di Membro Platinum dell’Embedded Vision Alliance, Xilinx ha già sintetizzato 30 degli algoritmi di visione embedded più usati dalla libreria OpenCV per la propria piattaforma SoC Zynq, usando il tool Vivado HLS all’interno della serie di tool di progettazione Vivado®, e ciò consente agli sviluppatori di effettuare compromessi a livello di sistema tra la progettazione del processore e la progettazione logica. Questo livello di prestazioni e di flessibilità sarà determinante nell’ambito dell’evoluzione di sistemi di visione più intelligenti, fornendo agli OEM la piattaforma ideale sulla quale è possibile realizzare soluzioni più intelligenti.