Nel mondo dell'elettronica e della tecnologia, la durabilità dei dispositivi di archiviazione è sempre più importante. Infatti, il trend dell'archiviazione dei dati si trova in una continua e rapida evoluzione per poter rispondere alle sempre crescenti esigenze di storage delle moderne applicazioni come il computing ad alte prestazioni (HPC), i data center, l'analisi dei big data, il processo di transazioni online (OLTP), lo streaming di immagini ad alta risoluzione e le applicazioni di Intelligenza Artificiale (AI). Ognuna di queste applicazioni appena citate richiede soluzioni di archiviazione specifiche che siano veloci e affidabili, e capaci di gestire enormi quantità di dati in modo efficiente. In questo articolo, andremo ad approfondire alcune tecnologie alla base degli SSD U.2 di Transcend, concepiti appunto per applicazioni specifiche ad alte prestazioni.

I grandi sistemi di elaborazione della tecnologia moderna richiedono specifiche esigenze di prestazioni e robustezza per i dispositivi di archiviazione. Per questo motivo, il trend dell'archiviazione dei dati sta cambiando per rispondere alle esigenze delle applicazioni moderne, con un focus crescente su velocità, efficienza energetica e capacità di gestione di grandi volumi di dati. Ad esempio, nel computing ad alte prestazioni (HPC), la necessità di elaborare grandi volumi di dati con velocità straordinarie richiede dispositivi di archiviazione estremamente veloci ed a bassa latenza. Gli SSD con tecnologia NVMe (Non-Volatile Memory Express) sono diventati dunque lo standard per tali applicazioni, grazie alla loro capacità di offrire elevate velocità di lettura e scrittura, riducendo i colli di bottiglia nelle prestazioni. Ad esempio, nei supercomputer utilizzati per simulazioni scientifiche o modelli climatici, l'accesso rapido ai dati è fondamentale per eseguire calcoli complessi in tempi ridotti. Anche i data center, che ormai costituiscono il cuore delle infrastrutture digitali, hanno adottato soluzioni di archiviazione a stato solido per aumentare l'efficienza energetica e ridurre l’ingombro di archivi sempre più grandi. Un esempio pratico è l'adozione di SSD U.2 in data center hyperscale, che consente una maggiore densità di archiviazione e una gestione del calore più efficace.

Un ulteriore esempio sono i sistemi di analisi dei big data, i quali richiedono la capacità di gestire e analizzare rapidamente grandi quantità di informazioni provenienti da diverse fonti. Le soluzioni di archiviazione basate su architetture distribuite, come Hadoop Distributed File System (HDFS) e Amazon S3, sono essenziali per supportare questi carichi di lavoro. Tali sistemi permettono di distribuire i dati su più nodi, garantendo scalabilità e resilienza. Ad esempio, aziende come Netflix utilizzano questi sistemi per analizzare i dati degli utenti e ottimizzare le raccomandazioni dei contenuti in tempo reale. Il processo di transazioni online (OLTP) richiede soluzioni di archiviazione con elevate prestazioni di IOPS (Input/Output Operations Per Second) per gestire un grande numero di operazioni simultanee. Le applicazioni di Intelligenza Artificiale (AI) e Machine Learning (ML) richiedono soluzioni di archiviazione capaci di gestire dataset enormi e complessi. Gli SSD NVMe, in combinazione con le tecnologie di archiviazione scalabile come Ceph e GlusterFS, permettono una rapida accessibilità ai dati necessari per l'addestramento e l'implementazione dei modelli AI.

L'innovativo SSD U.2 UTE210T di Transcend rappresenta una significativa evoluzione dei dispositivi di archiviazione a prestazioni elevate. Progettato con flash NAND 3D a 112 livelli e un controller ad 8 canali, questo SSD sfrutta l'interfaccia PCIe Gen 4x4 per offrire velocità di trasferimento dati senza precedenti. La cache DRAM integrata consente elevate velocità di lettura e scrittura randomica, migliorando l'efficienza operativa in scenari di utilizzo intensivo.

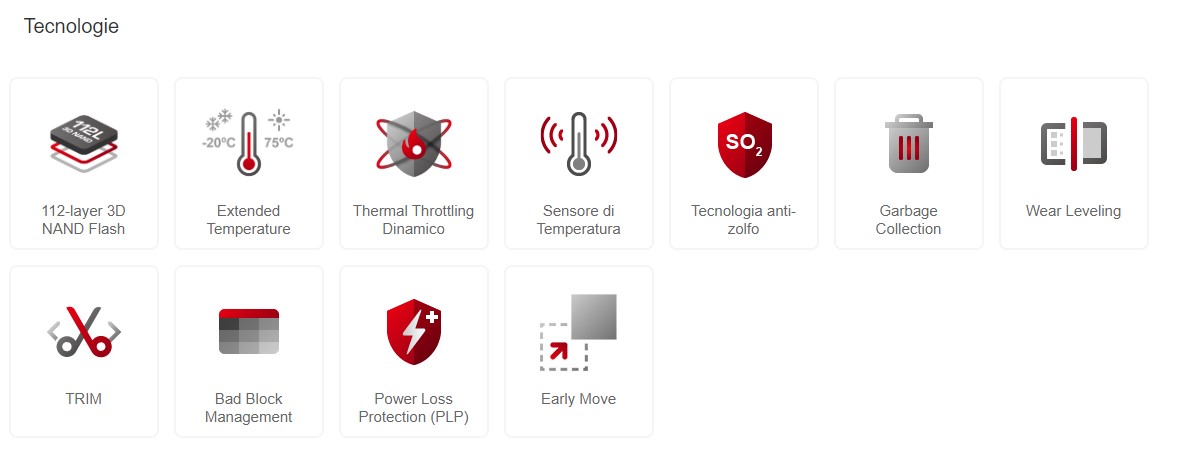

La struttura a 112 livelli della NAND flash non solo aumenta la densità di archiviazione, ma migliora anche la durata e l'affidabilità del dispositivo. Con una capacità che varia da 512 GB fino a 8 TB, l'UTE210T è in grado di soddisfare le esigenze di applicazioni critiche come il computing ad alte prestazioni (HPC), i data center, l'analisi dei big data, e l'elaborazione delle transazioni online (OLTP). La velocità di lettura sequenziale può raggiungere i 7000 MB/s, mentre la velocità di scrittura arriva fino a 6300 MB/s. Di seguito, andremo ad osservare le principali tecnologie (Figura 1) che Transcend adotta in questo dispositivo top di gamma per garantire le prestazioni e la robustezza necessaria ad applicazioni come datacenter e HPC. In particolare, approfondiremo:

- tecnologia antizolfo

- garbage collection

- wear leveling

- bad block management

- early move

- TTD- Thermal Throttling Dinamico

Figura 1: Tecnologie utilizzate negli SSD U.2 UTE210T (Fonte: Transcend)

Tecnologia Antizolfo

Uno dei principali nemici dei dispositivi di archiviazione è lo zolfo, un elemento che può compromettere seriamente la funzionalità dei circuiti integrati. Infatti, lo zolfo presente nell'ambiente, può penetrare nei circuiti integrati e causare corrosione, interrompendo i segnali elettrici e portando al guasto del dispositivo. Questa problematica è particolarmente accentuata in ambienti industriali e urbani, dove la concentrazione di zolfo è elevata. La tecnologia antizolfo si basa su rivestimenti speciali e materiali avanzati che impediscono allo zolfo di interagire con i componenti elettronici.

Questi rivestimenti sono progettati per essere altamente resistenti alla corrosione, offrendo una protezione duratura. I materiali utilizzati, come i polimeri avanzati e le leghe metalliche, creano una barriera efficace contro l'infiltrazione di zolfo. La tecnologia antizolfo sta emergendo come una soluzione innovativa per proteggere i componenti elettronici, migliorando la longevità e l'affidabilità dei dispositivi di archiviazione. L'adozione di queste tecniche rappresenta un passo avanti significativo per l'industria dell'archiviazione dei dati al fine di garantire una maggiore affidabilità dei dispositivi, riducendo i costi di manutenzione e i rischi di perdita di dati.

Garbage Collection

Per mantenere alte prestazioni nel tempo, gli SSD utilizzano un processo chiamato "garbage collection", ossia un processo di gestione della memoria che permette agli SSD di ottimizzare lo spazio di archiviazione. Vediamo nel dettaglio come funziona.

Quando i dati vengono scritti su un SSD, essi sono memorizzati in blocchi e pagine. Nel tempo, alcune di queste pagine possono diventare obsolete o non più necessarie. Tuttavia, gli SSD non possono semplicemente sovrascrivere i dati esistenti; devono prima cancellare i blocchi interi che contengono queste pagine obsolete. Qui, è dove entra in gioco la tecnica di garbage collection. Il processo, infatti, identifica e raccoglie le pagine di dati inutilizzati o obsoleti, copia e consolida le pagine ancora valide in nuovi blocchi, infine cancella e libera i blocchi vecchi rendendoli disponibili per nuove scritture. Questo processo avviene in background e si capisce bene come può influenzare le prestazioni del dispositivo.

Tuttavia, la tecnica ha dei pro e contro. Se è vero che ottimizza gli spazi disponibili per poter scrivere, il processo richiede risorse che impattano necessariamente sulle prestazioni di scrittura dell’SSD. Inoltre, il processo di garbage collection, se non ottimizzato, può accelerare il consumo dei cicli di scrittura del dispositivo di archiviazione. Tuttavia, le tecniche moderne come il Wear Leveling distribuiscono uniformemente l'usura, mitigando questo problema.

Wear leveling

Il "wear leveling", che abbiamo appena citato, è una tecnica fondamentale nei dispositivi SSD, che mira a distribuire uniformemente le operazioni di scrittura tra tutte le celle di memoria, prevenendo l'usura prematura di alcune aree specifiche. Questa tecnica è determinante perché le celle di memoria NAND, utilizzate negli SSD, hanno un numero limitato di cicli di scrittura e cancellazione, noti come Program/Erase (P/E) cycles. Senza un adeguato wear leveling, alcune celle potrebbero raggiungere il loro limite di cicli molto più velocemente di altre, riducendo la vita utile dell'intero SSD. Il wear leveling può essere suddiviso in due categorie principali: statica e dinamica. Il wear leveling dinamico interviene ogni volta che viene scritto un nuovo dato, assicurandosi che le nuove scritture vengano distribuite tra le celle meno utilizzate, questo approccio è efficace per evitare l'usura rapida di celle frequentemente scritte, ma non risolve completamente il problema delle celle meno utilizzate che contengono dati statici. Il wear leveling statico, invece, sposta periodicamente i dati statici, che non cambiano spesso, in celle diverse per garantire che anche queste celle siano soggette a cicli di scrittura. In questo modo, l'usura è distribuita più equamente su tutto il dispositivo. Un esempio pratico del funzionamento del wear leveling può essere visto nell'uso quotidiano di un SSD in un laptop.

Bad Block management

Il "bad block management" è una tecnica critica nei dispositivi SSD per garantire l'integrità e l'affidabilità dei dati. I bad block sono settori della memoria NAND che non funzionano correttamente e non possono più memorizzare dati in modo affidabile. Questo, può accadere a causa di vari fattori, come difetti di fabbricazione, usura nel tempo o danni fisici. La gestione dei bad block è un aspetto essenziale per mantenere le prestazioni e la longevità dell'SSD, soprattutto in applicazioni che gestiscono enormi quantità di dati. Quando un SSD identifica un bad block, lo segna come non utilizzabile e trasferisce i dati contenuti in quel blocco in un altro blocco sano. Questo processo è noto come remapping e viene gestito dal controller dell'SSD.

La tecnica di wear leveling, combinata con il bad block management, garantisce che i blocchi difettosi siano gestiti efficacemente, riducendo al minimo l'impatto sulle prestazioni complessive del dispositivo. Un altro esempio pratico è l'uso dei blocchi di riserva (spare blocks). Gli SSD sono progettati con una certa quantità di spazio extra per sostituire i bad block. Quando un blocco diventa inutilizzabile, il controller dell'SSD lo sostituisce con uno di questi blocchi di riserva. Questo processo è trasparente per l'utente e garantisce che la capacità di archiviazione rimanga costante nel tempo. Durante le operazioni di lettura e scrittura, il controller esegue controlli di integrità per assicurarsi che i dati non siano corrotti. Se viene rilevato un errore, il controller utilizza algoritmi di correzione degli errori (ECC) per recuperare i dati e, se necessario, sostituisce il blocco difettoso con uno sano. Questa gestione proattiva dei bad block è critica per le applicazioni che richiedono un'elevata affidabilità, come i server aziendali e i data center.

Early Move

Il concetto di early move si basa sull'idea di anticipare le operazioni di spostamento dei dati dai blocchi di memoria in uso ai blocchi di riserva, prima che diventino effettivamente necessari. Questo approccio proattivo permette di ridurre l'usura dei blocchi di memoria e di mantenere le prestazioni elevate dell'SSD. Durante il normale funzionamento di un SSD, i dati vengono continuamente scritti e cancellati, causando un'usura inevitabile delle celle di memoria NAND. Con l'early move, il controller dell'SSD monitora costantemente l'utilizzo dei blocchi e prevede quando un blocco potrebbe diventare troppo usurato per continuare a funzionare in modo affidabile. In tal caso, i dati vengono spostati in un blocco meno usurato prima che si verifichino problemi.

Thermal Throttling Dinamico

Il "thermal throttling dinamico" è una tecnica fondamentale per la gestione delle temperature nei dispositivi SSD e per prevenire il surriscaldamento che potrebbe avere impatti su prestazioni e affidabilità del dispositivo di archiviazione. Il thermal throttling dinamico interviene riducendo temporaneamente le prestazioni dell'SSD per mantenere le temperature entro limiti di sicurezza, evitando danni ai componenti e garantendo una maggiore longevità del dispositivo. La tecnica è basata su sensori di temperatura integrati nel controller che monitorano continuamente la temperatura. Quando questa supera una soglia predefinita, il controller riduce automaticamente la velocità di trasferimento dei dati per diminuire la generazione di calore. Una volta che la temperatura rientra nei limiti di sicurezza, il controller ripristina gradualmente le prestazioni normali.

Conclusioni

In questo articolo, abbiamo osservato come Transcend adotta soluzioni tecnologiche e metodologie avanzate per migliorare l'affidabilità dello storage dei dati all'interno dei propri prodotti SSD, in particolar modo il modello UTE210T in formato U.2 concepito per applicazioni spinte quali i data center. Il trend della memorizzazione dei dati è sempre in continua evoluzione e vedremo, da parte dei produttori, nuove soluzioni e tecniche al fine di incrementare le prestazioni e la robustezza dei dispositivi di memorizzazione.

Per ulteriori informazioni, potete contattare il team Transcend Italia al seguente indirizzo email: team_is-nl@transcend-info.com

Riferimenti

Di seguito, riporto alcuni link di approfondimento per i più curiosi.

[1] Transcend - UTE210T

[2] Transcend - 112-layer 3D NAND Flash

[3] Transcend - Tecnologia antizolfo

[4] Transcend - Garbage Collection