L’integrazione dell’Intelligenza Artificiale su microcontrollori rappresenta una sfida affascinante nel campo dell’elettronica embedded. Dopo aver esplorato la creazione e l’addestramento di un modello di Machine Learning, è ora fondamentale comprendere come implementarlo correttamente su una scheda Arduino, garantendo al contempo efficienza e ottimizzazione delle risorse hardware. L’obiettivo principale è riuscire a ottenere inferenze rapide e accurate senza compromettere il consumo energetico o sovraccaricare il microcontrollore. Per farlo, è necessario adottare una serie di strategie di ottimizzazione che spaziano dalla gestione della memoria alla riduzione della latenza di esecuzione, garantendo che il modello funzioni in modo stabile anche in applicazioni real-time.

Preparazione dell’ambiente di sviluppo

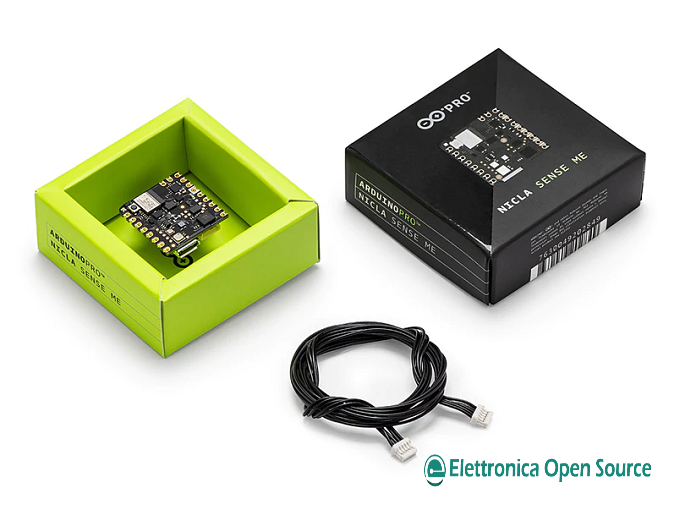

Per eseguire un modello AI su Arduino, è necessario configurare un ambiente di sviluppo adeguato. L’uso di TensorFlow Lite for Microcontrollers permette di eseguire modelli ottimizzati direttamente sulla scheda, senza dipendere da connessioni esterne. L’ambiente di sviluppo include strumenti come Arduino IDE, Python per la conversione del modello e librerie specifiche per la gestione dei sensori. Una configurazione errata dell’ambiente di sviluppo può portare a errori di esecuzione, rallentamenti e problemi di compatibilità tra il modello AI e la piattaforma hardware. Un aspetto essenziale è la scelta della scheda hardware. Microcontrollori come l’Arduino Nano 33 BLE Sense offrono capacità computazionali adeguate, con sensori integrati che permettono l’acquisizione e l’elaborazione di dati in tempo reale. Il corretto bilanciamento tra potenza di calcolo e consumo energetico è fondamentale per garantire prestazioni ottimali senza compromettere la durata operativa del dispositivo. È importante valutare anche le esigenze specifiche dell’applicazione: alcune implementazioni possono richiedere schede con maggiore RAM o capacità di elaborazione dati, mentre altre possono funzionare con hardware più economico e meno potente.

Caricamento e ottimizzazione del modello

Una volta configurato l’ambiente, il modello addestrato deve essere convertito in un formato compatibile con Arduino. TensorFlow Lite utilizza tecniche di quantizzazione per ridurre la dimensione del modello, trasformando i pesi da numeri a 32 bit a rappresentazioni più leggere a 8 bit. Questo processo permette di diminuire il consumo di memoria e migliorare la velocità di inferenza, rendendo il modello più adatto all’esecuzione su dispositivi embedded. La riduzione del consumo di memoria è particolarmente importante nei microcontrollori, dove ogni kilobyte di RAM è prezioso e un uso inefficiente delle risorse potrebbe compromettere l’intero funzionamento del sistema. L’ottimizzazione non riguarda solo il modello AI, ma anche il codice che lo esegue. È possibile migliorare le prestazioni gestendo efficientemente l’allocazione della memoria, utilizzando buffer ottimizzati e minimizzando le operazioni computazionali superflue. Inoltre, l’uso di interrupt e tecniche di elaborazione a bassa latenza consente di ridurre i tempi di risposta e migliorare la reattività del sistema. Un’ottimizzazione efficace prevede anche il monitoraggio dell’utilizzo della CPU durante l’esecuzione del modello, per individuare eventuali colli di bottiglia e adattare il codice per migliorare l’efficienza computazionale.

Debugging e test del modello AI

Una volta implementato il modello, è necessario effettuare test approfonditi per verificarne il corretto funzionamento. Il debugging può includere la verifica della precisione dell’inferenza, l’analisi dell’uso della memoria e l’ottimizzazione della gestione delle risorse hardware. Strumenti come il Serial Monitor di Arduino e tool di profiling della memoria permettono di identificare colli di bottiglia e ottimizzare ulteriormente l’esecuzione. Il test deve essere condotto in condizioni il più possibile simili a quelle operative, per assicurarsi che il modello risponda in modo affidabile a diverse condizioni ambientali e di utilizzo. L’implementazione di test automatizzati aiuta a garantire l’affidabilità del modello nel tempo. Simulare scenari reali con dati di test variabili consente di valutare la robustezza del modello e prevedere eventuali errori operativi prima della distribuzione finale. Un modello AI efficace non solo deve essere accurato nelle predizioni, ma deve anche essere in grado di gestire input rumorosi o imprevisti senza generare falsi positivi o falsi negativi eccessivi. Per questo, è utile applicare tecniche di validazione incrociata e testare il modello su dataset differenti per assicurarsi che funzioni correttamente in una varietà di situazioni pratiche.

Conclusione

L’implementazione di un modello AI su Arduino richiede un’attenta ottimizzazione delle risorse e una fase di debugging approfondita per garantire prestazioni elevate. Una gestione efficiente della memoria, l’uso di tecniche di quantizzazione e test accurati sono fondamentali per ottenere risultati affidabili. Nel prossimo articolo approfondiremo il miglioramento delle prestazioni AI su microcontrollori, esplorando strategie avanzate di ottimizzazione energetica e computazionale.