Il concetto di interazione virtuale è la base per il prossimo sviluppo di interfacce gestuali che trovano spazio soprattutto nei sistemi wearable di piccole dimensioni. Immaginate un pulsante invisibile tra il pollice e l'indice, è possibile premerlo toccando insieme le dita. O un quadrante virtuale che si accende per sfregamento di due dita. Immaginate di afferrare e tirare un cursore virtuale dal nulla. Tutte queste interazioni virtuali che sfiorano l’immaginazione rappresentano la tecnologia Soli. Soli è una nuova tecnica di rilevamento che utilizza segnali radar per analizzare le interazioni gestuali touchless. Il chip incorpora un'intera elettronica di elaborazione con sensore e un array di antenne, il tutto in un package ultra compatto di soli 10 mm x 8 mm.

Introduzione

Il riconoscimento dei gesti, insieme con quello facciale e vocale, il monitoraggio degli occhi e del movimento sono componenti essenziali che gli sviluppatori riferiscono ad un'interfaccia utente percettiva (PUI). L'obiettivo di PUI è quello di migliorare l'efficienza e la facilità d'uso di un design. I gesti sono una forma naturale di interazione umana. Come tale c'è stata molta ricerca nell’usare il gesture recognition (al seguente link una panoramica di articoli sulla gesture recognition) come un modo di interagire senza contatto con dispositivi elettronici. Si tratta di una tecnologia di rilevamento che utilizza un dispositivo radar in miniatura per rilevare le interazioni gesto touchless. Può essere inclusa in dispositivi indossabili, cellulari, computer, automobili e dispositivi IoT. Il progetto Soli ha la capacità di rilevare circa 3mila movimenti al secondo, attraverso una combinazione software e hardware che la Google insieme alla Infineon sono riusciti a realizzare in un unico chip. Gli algoritmi auto-apprendenti, inoltre, riconoscono i movimenti intenzionali (e non) relativamente a segnali elettrici opportunamente decodificati. Infineon è un leader nel mercato dei chip radar, offrendo soluzioni di componenti a livello di sistema per consumatori, sicurezza automobilistica, applicazioni di rilevamento e di visione industriale e commerciale. Il chip Soli in lavorazione dal 2011, ha l'obiettivo di monitorare il movimento della mano, in una sorta di trasduttore di energia cinetica in segnali elettrici. In questo caso i segnali elettrici rispondono in tempo e in ampiezza a seconda della gestualità delle mani (Figura 1).

Il sensore

Lo scopo principale del progetto di Google Soli è quello di utilizzare il segnale radar per decodificare i gesti del mondo reale al fine di controllare gli smartphone e gestire comodamente la navigazione SmartWatch. La tecnologia dei sensori funziona attraverso l'emissione di onde elettromagnetiche in un fascio molto ampio. Gli oggetti all'interno del fascio disperdono un livello di energia, tale da riflettere una piccola parte verso l'antenna radar. Le proprietà del segnale riflesso, come l'energia e il tempo di ritardo, forniscono informazioni sulla dinamicità dei spostamenti, tra cui le dimensioni, la forma, l'orientamento, il materiale, la distanza e la velocità.

Soli riconosce i gesti dinamici espressi dai movimenti delle dita e della mano, ed è in grado di distinguerli all'interno del suo campo di azione.

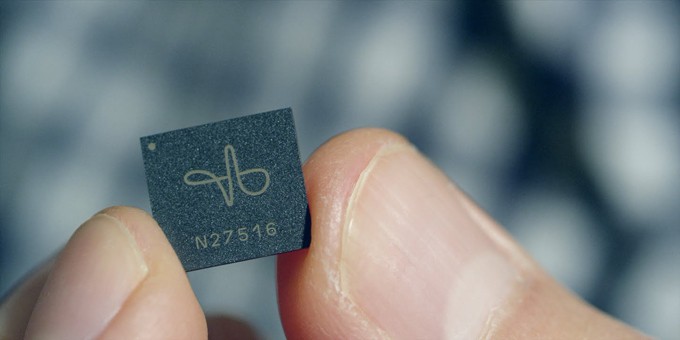

Per raggiungere questo obiettivo è stato sviluppato un nuovo chip radar di rilevamento, con software e algoritmi di analisi dati che ne completano l'elaborazione. Il sensore Soli è un radar a bassa potenza completamente integrato che opera nella banda ISM di 60 GHz. La realizzazione dei vari prototipi ha visto coinvolgere rapidamente diverse soluzioni hardware, ottenendo una soluzione ultra-compatta che può essere facilmente integrata in piccoli dispositivi consumer mobile e prodotti su larga scala. RADAR sta per RAdio Detecting And Ranging e come indicato dal nome, si basa sull'impiego di onde radio. I radar emettono onde elettromagnetiche simili a reti di computer wireless e telefoni cellulari. I segnali vengono inviati in forma di brevi impulsi che possono essere riflessi da oggetti durante il loro percorso, ritornando così verso il radar. Quando questi impulsi intercettano un oggetto, parte dell'energia dispersa torna al radar. Questo concetto è simile all’effetto di eco. Da queste informazioni il radar è in grado anche di stimare la quantità di precipitazione e la zona di interesse. Il chip Soli (Figura 2 e 3) riduce notevolmente la complessità del sistema radar e il consumo di energia rispetto ai primi prototipi. Sono state sviluppate due architetture di modulazione: una Frequency Modulated Continuous Wave (FMCW) e un Direct-Sequence Spread Spectrum (DSSS). Entrambi i chip integrano l'intero sistema radar comprese antenne multiple beamforming che consentono un tracking di imaging 3D senza parti in movimento. La tecnologia radar FMCW utilizza un'onda continua, in questo caso la differenza di frequenza tra il segnale trasmesso e quello riflesso viene utilizzato per calcolare la distanza di target. Direct Sequence Spread Spectrum (DSSS), invece, è una tecnica di modulazione dello spettro utilizzato per ridurre l'interferenza complessiva del segnale. La diffusione di questo segnale consente una maggiore resistenza alle interferenze involontarie e intenzionali.

Considerazioni e conclusioni

Ivan Poupyrev è il responsabile del progetto Soli del dipartimento ATAP di Google, in grado di incorporare un minuscolo chip radar in modo che si possa utilizzare i gesti delle mani per controllare il mondo digitale che ci circonda (Video 1).

Video 1: il progetto Google Soli e RadarCat

I ricercatori dell'Università di St Andrews in Scozia, sono riusciti a usare i radar del progetto Soli non solo per percepire gli oggetti vicini, ma anche a riconoscerli. I ricercatori hanno chiamato il nuovo tool come Radar Categorization for Input & Interaction, o RadarCat. Per creare questo nuovo tool, i ricercatori hanno utilizzato gli stessi principi alla base di computer vision che utilizzano l'intelligenza artificiale (machine learning) per analizzare le immagini. Attualmente, RadarCat può riconoscere una vasta gamma di semplici oggetti fissi come frutta e forniture per ufficio, ma può anche comprendere concetti più complessi, come la differenza tra un bicchiere vuoto e un bicchiere d'acqua, così come la differenza tra la parte anteriore e posteriore di un telefono.

Oltre al wearable potrebbe trovare spazio anche nei prossimi telefoni mobile, così come nelle soluzioni di interfaccia per sistemi automotive. Quale altra soluzione potrebbe competere con la gesture recognition ?