La ricerca sulla computazione quantistica affronta una delle sue prove più complesse: proteggere i qubit dal rumore elettromagnetico che ne compromette la stabilità. Un team internazionale ha introdotto una soluzione tecnologica che potrebbe segnare una svolta decisiva attraverso un approccio basato su algoritmi avanzati e hardware dedicato, che rende la correzione degli errori più rapida ed efficace. In tal modo, i processori quantistici diventano più potenti e affidabili. Le prospettive applicative spaziano dalla medicina all’informatica, delineando scenari di innovazione senza precedenti.

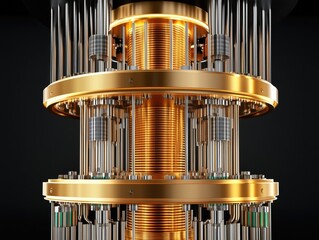

La computazione quantistica è oggigiorno uno dei settori più promettenti della scienza e della tecnologia contemporanea, ma la sua evoluzione si scontra con un ostacolo: la vulnerabilità dei qubit al rumore esterno. La fragilità intrinseca di questi elementi di calcolo deriva dalla loro natura quantistica, che risulta estremamente sensibile a perturbazioni ambientali anche minime. Quando i qubit perdono la loro coerenza a causa di interferenze elettromagnetiche, i processi di calcolo vengono compromessi e l’intero sistema rischia di perdere affidabilità. Un gruppo di ricerca che coinvolge l’Istituto Niels Bohr, il MIT, l’Università Norvegese di Scienza e Tecnologia e l’Università di Leiden, ha messo a punto un approccio innovativo per affrontare il problema. Lo studio, pubblicato su PRX Quantum, illustra un algoritmo denominato Frequency Binary Search, progettato per operare in tempo reale direttamente sul controller quantistico. Questa strategia consente di ridurre i tempi di correzione degli errori e superare il limite tradizionale che prevedeva il passaggio dei dati a sistemi esterni, troppo lenti per reagire alle rapide fluttuazioni del rumore.

Il controller utilizzato integra FPGA, dispositivi programmabili che permettono un’elaborazione parallela ad alta velocità. Grazie a questa architettura, è possibile monitorare e correggere simultaneamente la frequenza dei qubit e le sue variazioni. L’algoritmo interviene in modo rapido e mirato, offrendo la possibilità di calibrare in modo preciso un numero crescente di qubit senza la necessità di effettuare migliaia di misurazioni come avviene con le tecniche convenzionali.

Secondo i ricercatori coinvolti, la novità risiede sia nell’efficienza dell’algoritmo sia nella possibilità di programmare l’hardware con linguaggi di alto livello, più accessibili rispetto ai metodi tradizionali, il che consente di unire competenze provenienti da discipline diverse, come la fisica dei sistemi superconduttori e l’ingegneria elettronica, per accelerare la sperimentazione e l’implementazione di soluzioni concrete.

Le implicazioni di un simile progresso sono di ampia portata. L’attuale generazione di processori quantistici conta alcune centinaia di qubit, ma gli sviluppi futuri potrebbero portare a dispositivi con milioni di unità. In tale scenario, la capacità di calibrare l’intero sistema con un numero ridotto di misurazioni è un vantaggio strategico in termini di tempo, risorse e stabilità complessiva. La ricerca evidenzia anche l’importanza di affrontare la decoerenza quantistica con strumenti che siano teoricamente validi e pratici per un’implementazione su larga scala. Con un metodo capace di reagire in tempo reale, le possibilità applicative della tecnologia quantistica diventano più concrete. Settori come la medicina personalizzata, la progettazione di nuovi materiali, la simulazione di molecole complesse e la cybersicurezza potrebbero trarre vantaggio da sistemi quantistici più stabili e precisi.

Il superamento della barriera del rumore diventa quindi un passo decisivo verso la maturità tecnologica della computazione quantistica. Oltre a costituire un progresso tecnico, l’introduzione della Frequency Binary Search è anche un segnale che l’unione di competenze interdisciplinari è in grado di generare soluzioni capaci di trasformare prospettive teoriche in applicazioni reali.