L’edge AI rappresenta la combinazione tra Intelligenza Artificiale ed edge computing, ovvero la possibilità di raccogliere dati, elaborarli e fornire risultati per prendere decisioni informate, direttamente sul dispositivo locale "ai margini" della rete, senza la necessità di inviare dati al cloud. Oltre ad essere uno dei punti cardine della democratizzazione dell'Intelligenza Artificiale, l'elaborazione edge è fondamentale in applicazioni che richiedono bassa latenza, riservatezza dei dati, ridotto consumo energetico e operatività offline, come nel caso di robotica, domotica, droni e dispositivi IoT. Per supportare questi scenari, sono necessarie schede elettroniche capaci di bilanciare prestazioni AI e ottimizzazione hardware, ed è proprio su queste che ci concentreremo nell'articolo.

Introduzione

Nel 2025, l’Intelligenza Artificiale è entrata in modo profondo in ogni settore tecnologico, anche grazie allo sviluppo di schede elettroniche sempre più sofisticate in grado di eseguire modelli AI direttamente su dispositivi edge. Dall’Industria 4.0 alla robotica personale, dalla videosorveglianza smart sino ai veicoli autonomi, la richiesta di soluzioni hardware dedicate non accenna a diminuire. L'obiettivo principale non è soltanto garantire adeguata potenza di calcolo, ma anche ridurre i consumi energetici, migliorare la compatibilità con framework AI e offrire un robusto ecosistema di sviluppo. Il mercato elettronico offre oggi una gamma alquanto diversificata di soluzioni, ognuna con caratteristiche uniche, ma che hanno in comune l'essere dei dispositivi hardware con vincoli in termini di risorse computazionali ed energetiche. Comprendere le differenze tra le principali piattaforme consente di effettuare scelte più consapevoli e massimizzare l’efficienza dei progetti di Intelligenza Artificiale, diventata ormai una tecnologia indispensabile anche per il funzionamento dei dispositivi portatili più compatti ed economici. Come abbiamo accennato in precedenza, l’elaborazione dei dati non avviene più solo nel cloud ma direttamente sui devices fisici grazie a schede elettroniche sempre più potenti, efficienti e specializzate, veri e propri piccoli computer progettati per gestire inferenze AI in tempo reale, che stanno innovando settori come la robotica, l’automazione industriale, la videosorveglianza intelligente e l’IoT. Scegliere la giusta piattaforma hardware è diventato un passaggio essenziale per lo sviluppo di soluzioni scalabili e performanti. In questa guida vengono analizzate le migliori schede elettroniche del momento per l’Intelligenza Artificiale, mettendo in evidenza caratteristiche, prestazioni e possibili scenari d’uso.

Come scegliere la giusta scheda per applicazioni di Intelligenza Artificiale

La scelta della giusta scheda elettronica per applicazioni di Intelligenza Artificiale dipende da diversi fattori legati all'uso specifico, alla potenza di calcolo richiesta e al budget disponibile. Prima di tutto, è fondamentale capire il tipo di applicazione IA: visione artificiale, elaborazione del linguaggio, robotica, edge computing o reti neurali complesse. Per compiti leggeri come il semplice riconoscimento vocale o di immagini, una scheda come Raspberry Pi 4 o Google Coral Dev Board può bastare. Per applicazioni più complesse è meglio puntare su schede dotate di GPU o TPU integrate, come la NVIDIA Jetson Nano, Jetson Xavier NX o la Jetson Orin, progettate appositamente per eseguire inferenze AI in tempo reale. Un altro aspetto da considerare è la potenza di calcolo. Le reti neurali convoluzionali (CNN) o modelli Transformer richiedono un'elevata capacità di elaborazione parallela. A seconda del modello AI, potrebbe essere necessario optare per schede con CUDA cores, Tensor cores o acceleratori AI dedicati. La memoria RAM e la capacità di archiviazione sono altrettanto importanti per gestire dataset, modelli e librerie come TensorFlow o PyTorch. Bisogna poi considerare le interfacce di connessione (USB, GPIO, CSI, I2C) e il supporto per sensori o periferiche esterne. Infine, è necessario valutare la compatibilità software, il supporto della community e la disponibilità di esempi o tool specifici di AI per semplificare lo sviluppo. Schede con un forte ecosistema e documentazione (come quelle NVIDIA o Google Coral) facilitano il processo. E' chiaro quindi che la scelta della scheda dipende dal giusto equilibrio tra potenza, consumo, connettività e supporto per librerie AI, in funzione delle esigenze specifiche del progetto. Analizziamo alcune delle soluzioni presenti sul mercato.

Jetson Orin: potenza estrema in formato compatto

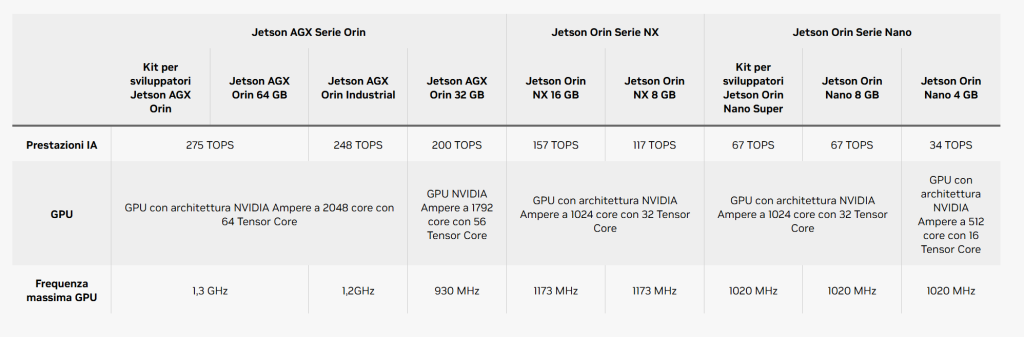

Nvidia continua ad essere uno dei principali protagonisti nel campo dell’hardware AI, soprattutto per quanto riguarda il calcolo distribuito e l’elaborazione edge. La serie Jetson, aggiornata nel 2025 con i modelli Orin Nano e Orin NX, segna un ulteriore salto generazionale. Jetson Orin Nano è disponibile in versioni da 20 e 40 TOPS, con un'architettura basata su GPU Ampere e CPU ARM Cortex-A78AE. L’integrazione nativa con CUDA, TensorRT, cuDNN e il supporto completo al pacchetto Nvidia JetPack rende l’intero ambiente estremamente potente e flessibile. Orin NX è pensata per applicazioni più complesse come l’automazione industriale avanzata, la gestione di robot collaborativi e l’analisi video multi-stream ad alta risoluzione.

Figura 1: Jetson Orin serie NX

Figura 2: Jetson Orin serie Nano

Figura 3: Jetson AGX serie Orin

Le schede Jetson sono pensate per chi ha bisogno di calcolo AI in tempo reale, con supporto a modelli Deep Learning di grandi dimensioni e capacità di eseguire simultaneamente più reti neurali. Un ulteriore punto di forza è rappresentato dalla disponibilità di moduli industriali con fattori di forma compatibili con carrier board personalizzabili, offrendo la possibilità di progettare dispositivi su misura per il deployment commerciale.

Figura 4: Specifiche tecniche della serie Jetson Orin

La gamma NVIDIA Jetson Orin comprende sette moduli con la stessa architettura, che offrono fino a 275 trilioni di operazioni al secondo (TOPS) e otto volte le prestazioni rispetto alla generazione precedente per l’inferenza IA multimodale, oltre al supporto dell'interfaccia ad alta velocità. Il potente stack software include modelli IA pre-addestrati, flussi di lavoro di riferimento e framework di applicazioni verticali, che accelerano lo sviluppo end-to-end per l’IA generativa e qualsiasi applicazione di robotica e IA edge.

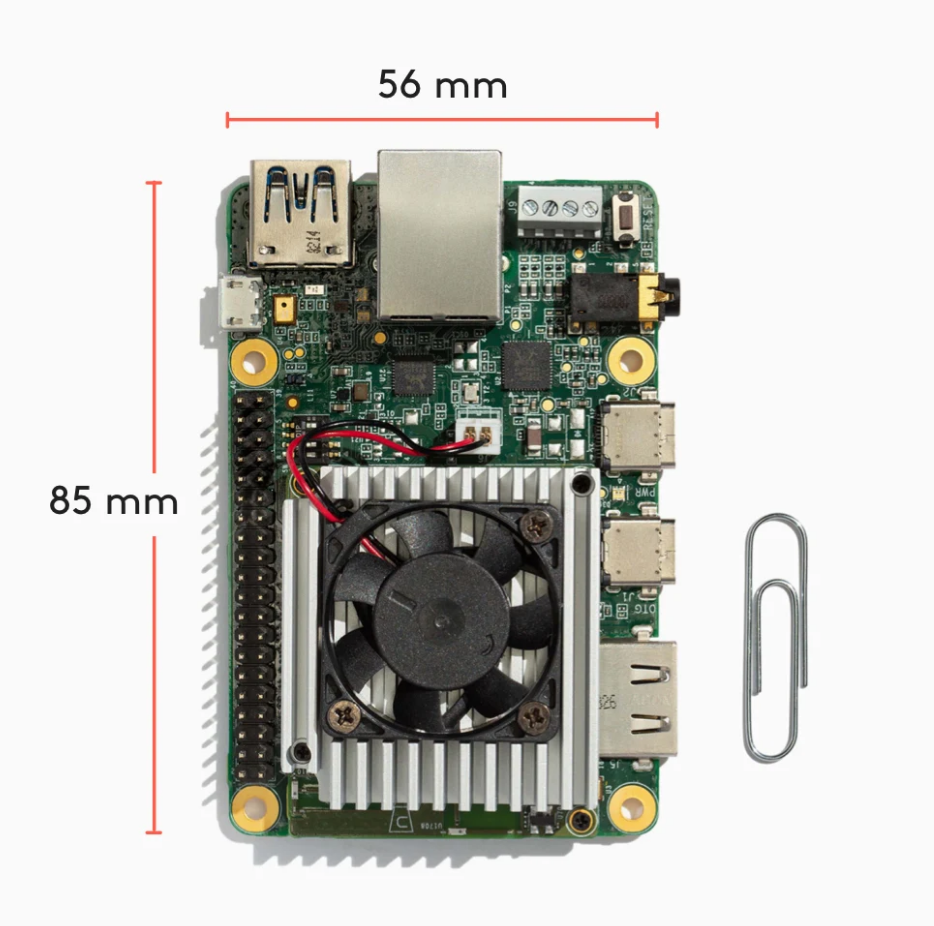

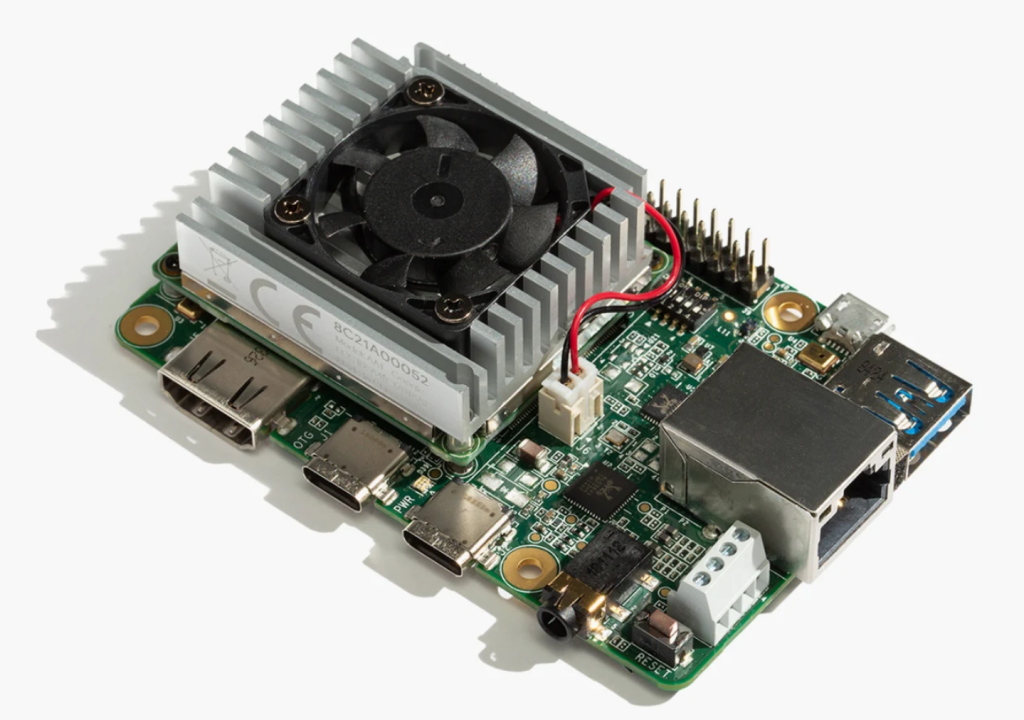

Coral Dev Board: inferenza leggera ottimizzata per TensorFlow Lite

Google, con la sua linea Coral, propone un approccio focalizzato sull’efficienza e sulla semplicità di sviluppo per prototipare rapidamente prodotti ML (Machine Learning) sul dispositivo. Coral Dev Board è un computer a scheda singola (single board computer) ideale quando è necessario eseguire inferenze di Machine Learning veloci in un fattore di forma ridotto. È possibile utilizzare la scheda di sviluppo per prototipare il sistema embedded e quindi scalare alla produzione utilizzando il System-on-Module (SoM) integrato combinato con l'hardware PCB personalizzato. La Coral Dev Board tiene conto delle nostre esigenze di scalabilità dal prototipo alla produzione, il SoM può essere rimosso dalla scheda base, ordinato in blocco e integrato nell'hardware. È possibile acquistare il SoM separatamente.

Il vantaggio principale risiede nella possibilità di eseguire inferenze locali con latenza ridotta, rendendo la board perfetta per soluzioni come sistemi smart home, dispositivi portatili, controlli ambientali e automazione leggera. Il sistema operativo Mendel, basato su Debian, fornisce un ambiente semplice ma completo per sviluppare e testare applicazioni AI. La scheda di sviluppo Coral Dev Board è apprezzata anche per la presenza di GPIO e periferiche I/O che consentono un’interazione diretta con il mondo fisico, il che semplifica la realizzazione di prototipi funzionali. Sebbene le prestazioni grezze siano inferiori rispetto ad altre schede più costose, l’ottimizzazione del motore Edge TPU garantisce risultati sorprendenti su modelli quantizzati. Chi lavora con TensorFlow Lite troverà nei dispositivi Coral una soluzione snella ed efficiente, ideale per progetti di inferenza AI distribuita.

Figura 5: Scheda Coral Dev Board

Figura 6: Scheda Coral Dev Board

Coral Dev Board utilizza un’unità Edge TPU capace di elaborare modelli AI a 4 TOPS, ottimizzati per TensorFlow Lite. Il coprocessore Edge TPU integrato è in grado di eseguire 4 trilioni di operazioni al secondo utilizzando 0,5 watt per ogni TOPS (2 TOPS per watt). Ad esempio, è in grado di eseguire modelli di visione mobile all'avanguardia come MobileNet v2 a quasi 400 FPS, in modo efficiente dal punto di vista energetico. Inoltre, grazie al pieno supporto per TensorFlow Lite, non c'è bisogno di costruire modelli da zero, i modelli TensorFlow Lite possono infatti essere compilati per l'esecuzione su Edge TPU. Coral Dev Board fornisce un sistema completo SoC + ML + connettività wireless, e permette di eseguire i nostri strumenti Linux preferiti con questa scheda.

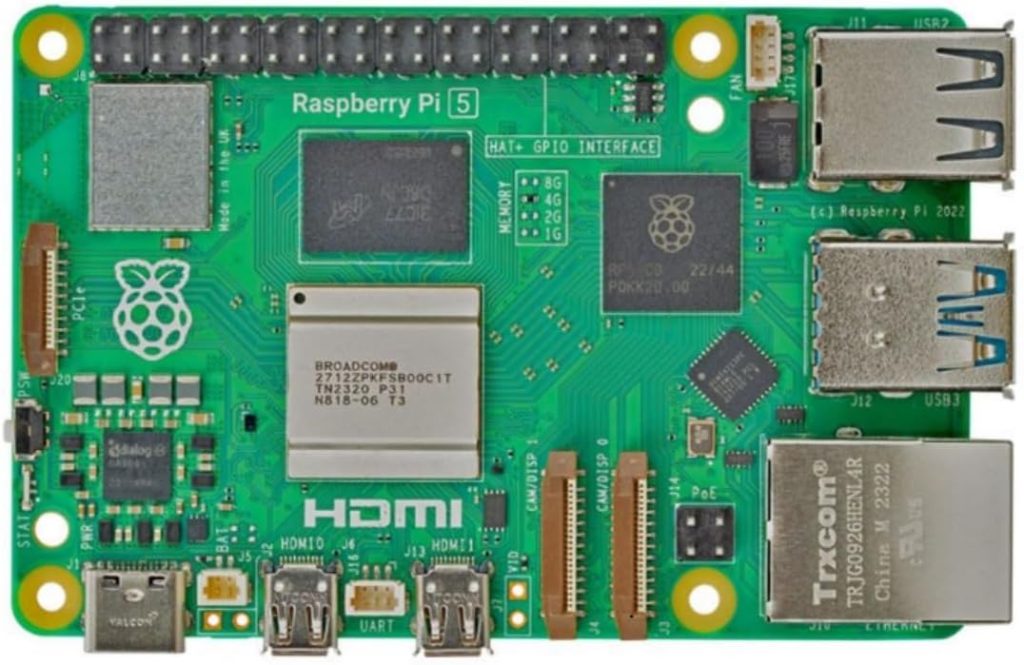

La democratizzazione dell’Intelligenza Artificiale porta il nome del Raspberry Pi 5

Nel corso degli anni, Raspberry Pi ha rappresentato una delle piattaforme più diffuse per la sperimentazione, l’istruzione e lo sviluppo embedded. Con Raspberry Pi 5, rilasciato nel tardo 2024 e potenziato nel 2025, il salto qualitativo è netto: l’introduzione di CPU quad-core ARM Cortex-A76 a 2.4 GHz, supporto per interfacce PCIe, doppia uscita video 4K e un netto miglioramento nella gestione energetica lo rendono molto più competitivo anche per applicazioni AI. Utilizzando acceleratori esterni, come Google Coral USB o Hailo-8 M.2, Raspberry Pi 5 diventa un’ottima piattaforma edge per applicazioni di visione artificiale, classificazione di immagini, riconoscimento facciale e monitoraggio di parametri ambientali. L’enorme ecosistema di software open source e la disponibilità di tutorial e guide tecniche permettono a chiunque, dai makers agli sviluppatori professionisti, di avvicinarsi all’Intelligenza Artificiale senza dover affrontare investimenti elevati o complesse curve di apprendimento. Un ulteriore vantaggio della board è la sua modularità: l’accesso a porte GPIO, CSI, DSI e connettori standard permette una facile integrazione con telecamere, sensori e attuatori.

Figura 7: Scheda di sviluppo Raspberry Pi 5 4GB

Hailo-8: inferenza potente con consumi minimi

Hailo si è affermata come una delle realtà emergenti più interessanti nel settore degli acceleratori neurali. Il chip Hailo-8 di edge AI è in grado di elaborare fino a 26 TOPS consumando meno di 2,5 W, caratteristica che lo rende ideale per applicazioni edge ad alta efficienza e che fà di Hailo un dispositivo oltre le prestazioni di tutti gli altri processori edge. I moduli basati su Hailo-8 sono oggi adottati da molti produttori hardware, che li integrano in sistemi industriali, videocamere intelligenti e unità di controllo per veicoli autonomi. Con un'architettura che sfrutta le proprietà principali delle reti neurali, il chip consente ai dispositivi periferici di eseguire applicazioni di Deep Learning su larga scala in modo più efficiente, efficace e sostenibile rispetto ad altri chip e soluzioni di Intelligenza Artificiale, riducendo notevolmente i costi. La sua area e l'efficienza energetica sono di gran lunga superiori ad altre soluzioni leader, con dimensioni inferiori anche includendo la memoria richiesta.

L’architettura è ottimizzata per reti neurali convoluzionali con accelerazione distribuita su una rete di core specializzati, che permette di mantenere prestazioni elevate anche in scenari complessi come l’elaborazione di flussi video in tempo reale, l’analisi predittiva o la gestione di eventi critici nei sistemi di sicurezza. Hailo fornisce anche un SDK proprietario e tool di conversione dei modelli compatibili con TensorFlow, ONNX e PyTorch, ed offre inoltre una pipeline completa dall’addestramento all’inferenza. Il supporto alla piattaforma Linux semplifica l'integrazione nei dispositivi edge professionali e riduce i tempi di sviluppo e deployment.

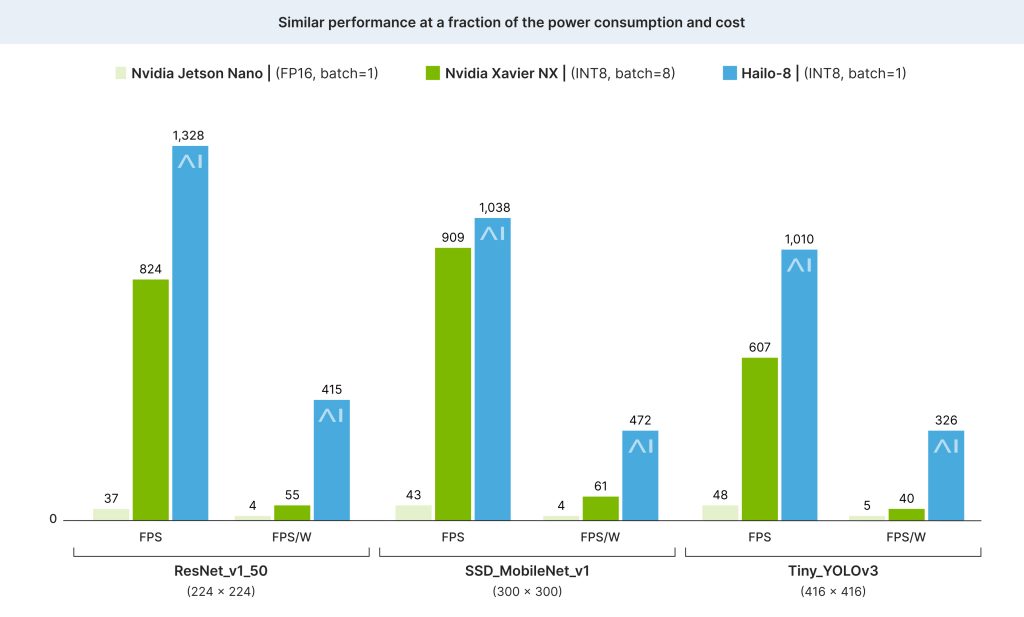

Figura 8: Diagramma di confronto delle prestazioni

I risultati di Xavier NX utilizzano batch=8 (mentre Hailo-8 e Jetson Nano utilizzano batch=1). Jetson Nano è limitato a FP16 (mentre Hailo-8 e Xavier NX sono INT8). I risultati di Nvidia per batch=1 e INT8, rispettivamente, dovrebbero essere inferiori.

I dati di Hailo-8 si basano sulla versione SDK 3.12.0 (novembre 2021), misurata a temperatura ambiente su un singolo dispositivo Hailo-8 tramite interfaccia PCIe su una scheda di valutazione Hailo (host di sistema: CPU Intel® Core™ i5-9400 @ 2,90 GHz). I dati su FPS e potenza per Nvidia Jetson Nano e Xavier NX provengono da:

https://developer.nvidia.com/embedded/jetson-benchmarks

Intel Movidius e OpenVINO: una combinazione flessibile per l’AI distribuita

Con hardware avanzato come CPU, GPU e VPU, unitamente a software ottimizzati, Intel contribuisce all’IA e supporta il suo sviluppo realizzando tecnologie innovative con migliori prestazioni computazionali e strumenti che facilitano l’adozione dell’Intelligenza Artificiale. L'azienda continua ad investire nel settore AI attraverso le sue soluzioni Movidius, che si posizionano in modo strategico tra GPU e FPGA. Il modulo Neural Compute Stick 2 (NCS2), basato sul chip Myriad X, si collega via USB e offre una potenza di calcolo di circa 1 TOPS, sufficiente per molte applicazioni edge leggere. Il modulo Intel Neural Compute Stick 2 è destinato ad applicazioni di Intelligenza Artificiale su dispositivi edge, come robotica, droni, videosorveglianza, smart home e IoT, e consente l’elaborazione veloce di reti neurali per visione artificiale e Deep Learning. La vera forza della soluzione Intel risiede nell’ambiente OpenVINO, un toolkit che consente di convertire e ottimizzare i modelli AI per l’esecuzione efficiente su CPU, GPU, VPU e FPGA Intel, accelerare l’inferenza e semplificare lo sviluppo di soluzioni AI. La possibilità di sviluppare su architetture eterogenee permette un'ampia flessibilità e facilità di porting tra diversi dispositivi, aspetto molto apprezzato nelle fasi di prototipazione rapida. I moduli basati su Movidius sono perfetti per l’analisi video, il riconoscimento oggetti, la biometria e tutte quelle situazioni in cui è necessaria una inferenza AI a bassa latenza in formato compatto.

Verso un’Intelligenza Artificiale davvero ubiqua

Nel 2025, l’hardware AI non è più un elemento accessorio, ma una componente strutturale di ogni progetto innovativo. L’adozione dell’Intelligenza Artificiale nei dispositivi embedded è ormai una realtà diffusa, mentre la disponibilità di schede elettroniche AI-ready consente di portare capacità computazionali avanzate in qualsiasi contesto, anche in ambienti remoti o con risorse limitate. Ogni piattaforma analizzata presenta distinti punti di forza e aree di applicazione preferenziali. Le soluzioni Nvidia dominano dove servono prestazioni massime, Coral punta sulla rapidità d’uso e sull’ecosistema Google, mentre Raspberry Pi resta una scelta strategica per progetti educativi o a budget contenuto. Hailo e Intel, con i loro approcci ottimizzati e flessibili, garantiscono invece risposte concrete a chi cerca potenza con consumi ridotti e strumenti professionali. La scelta della scheda ideale dipende quindi dal tipo di intelligenza che si desidera distribuire, dalla profondità del modello AI utilizzato e dalle condizioni operative in cui il sistema dovrà funzionare. Chi lavora nel mondo della tecnologia embedded deve tenere il passo con questa evoluzione per restare competitivo, efficiente e in grado di sviluppare soluzioni intelligenti e sostenibili che daranno forma al futuro dell'elettronica globale.

Considerazioni conclusive

Le schede elettroniche con Intelligenza Artificiale integrata rappresentano una svolta fondamentale per lo sviluppo di applicazioni smart in ambiti sempre più diversificati. Pensiamo alle soluzioni compatte ed a basso consumo per l’IoT, fino a quelle ad alte prestazioni per la visione artificiale e il Machine Learning, con un mercato che offre oggi diverse opzioni adatte a ogni esigenza progettuale. Scegliere la scheda giusta significa ottimizzare tempi, costi e risultati. Con il continuo avanzamento delle tecnologie embedded, il futuro dell’IA distribuita diventa più accessibile, potente e alla portata di makers, startup e aziende.