Quando tutto iniziò con una valvola

C’era un tempo in cui il termine calcolare era un verbo riservato a pochi eletti, e un computer occupava un’intera stanza. Nel 1946, l’ENIAC (Electronic Numerical Integrator And Computer) pesava 27 tonnellate, era composto da 18.000 valvole e consumava energia quanto un piccolo quartiere. Eppure, da quell’enorme groviglio di fili e calore nacque la scintilla della rivoluzione digitale. In meno di un secolo, il progresso tecnologico ha reso i calcolatori dei dispositivi tascabili, portando la potenza di elaborazione direttamente nelle nostre mani. Ma oggi, mentre i chip in silicio toccano i limiti della fisica, stiamo per attraversare un nuovo confine.

Figura 1: Sezione posteriore dell'ENIAC

Il futuro dell’informatica non si misurerà più in gigahertz o transistor, bensì nella capacità delle macchine di apprendere, intuire e affrontare problemi anche complessi che sfidano la logica classica, tutto ciò mentre l’Intelligenza Artificiale e la meccanica quantistica stanno fondendo due mondi, quello biologico e quello subatomico, per creare un nuovo paradigma computazionale. E' il preludio ad un’era in cui la potenza di calcolo smette di essere mera questione di velocità, acquisendo intelligenza fisica, distribuita e adattiva, capace di trasformare il modo stesso in cui pensiamo al concetto di computer.

Figura 2: Retro computer (Fonte: Adobe Stock)

Figura 3: IBM Personal Computer

Figura 4: Apple Computer Macintosh SE

Dal silicio al limite della miniaturizzazione

Per decenni, la legge di Moore è stata la bussola del progresso: ogni due anni, il numero di transistor su un chip raddoppiava, portando con sé potenza ed efficienza. Oggi, però, la miniaturizzazione si scontra con i confini della materia. I transistor moderni misurano pochi nanometri, appena una manciata di atomi. A queste scale, gli elettroni non obbediscono più alle regole della fisica classica, e il silicio comincia a mostrare i primi segni di cedimento. La dissipazione termica aumenta, la velocità non cresce più in modo proporzionale, ed i costi di produzione esplodono. È in questo scenario che la ricerca tecnologica ha aperto nuove strade: da un lato, l’informatica neuromorfica che imita la logica del cervello; dall’altro, l'informatica quantistica che sfrutta le leggi della meccanica dei quanti. Entrambe mirano a superare la barriera del modello di von Neumann, in cui memoria e calcolo sono separati. La sfida tecnologica supera la realizzazione di computer più piccoli, l'obiettivo diventa renderli più intelligenti, in grado di apprendere e risolvere problemi complessi in modi che la semplice logica binaria non può più sostenere.

Computer neuromorfici: il cervello dentro un chip

Immaginate ora un processore che non esegue istruzioni in sequenza, ma apprende dai dati, si adatta e riconosce schemi come fa un cervello umano. È la promessa dell’informatica neuromorfica. Ispirata alle reti neurali biologiche, questa nuova generazione di computer sostituisce la rigida architettura classica con una rete di neuroni elettronici interconnessi, capaci di elaborare e memorizzare simultaneamente. Progetti come Loihi di Intel, TrueNorth di IBM ed i più recenti chip basati su memristor stanno aprendo a sistemi con bassissimo consumo energetico e altissima efficienza cognitiva. Un sistema neuromorfico può riconoscere un volto o un suono consumando mille volte meno energia di una GPU tradizionale. In pratica, si tratta di chip che, oltre a rivoluzionare l’Intelligenza Artificiale, potrebbero trasformare il modo in cui interagiamo con le macchine rendendole progressivamente sempre più sensibili al contesto, più adattive e capaci di operare sul bordo della rete, senza bisogno di connessioni cloud. È l’informatica che si avvicina al pensiero biologico, un passo verso macchine che elaborano dati, e allo stesso tempo comprendono relazioni e costruiscono esperienze.

L’informatica quantistica

Nel mondo quantistico, la logica classica si dissolve. I bit diventano qubit, capaci di esistere contemporaneamente come 0 e 1 grazie al principio di sovrapposizione, proprietà che consente ai computer quantistici di esplorare simultaneamente un numero esponenziale di soluzioni, trasformando l’incertezza in potenza di calcolo. In pratica, mentre un computer tradizionale prova una soluzione alla volta, un computer quantistico le valuta tutte insieme. È un cambio di approccio che punta a trasformare settori come la crittografia, la simulazione molecolare, l’IA e l’ottimizzazione complessa. Nel lontano 2019, Google ha annunciato di aver raggiunto la supremazia quantistica, risolvendo in pochi minuti un problema per il quale un supercomputer classico avrebbe impiegato migliaia di anni, e da allora, IBM, Rigetti, IonQ, insieme a decine di startup, stanno portando la computazione quantistica fuori dai laboratori e dentro le piattaforme cloud. In parallelo, l’Europa investe miliardi nel progetto Quantum Flagship per non perdere terreno in una corsa globale. È un’epoca di sperimentazione intensa, dove il calcolo quantistico inizia ad uscire dal mito per entrare nella pratica.

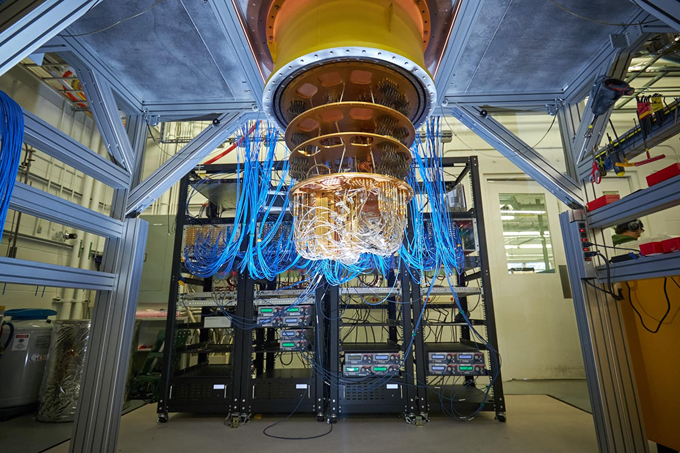

Figura 5: Computer quantistico

Due percorsi, un’unica destinazione: oltre l'architettura di von Neumann

A prima vista, i percorsi neuromorfico e quantistico sembrano opposti: uno imita il cervello, l’altro sfrutta le leggi della fisica quantistica, ma entrambi condividono la stessa ambizione, quella di superare i limiti del tradizionale modello di von Neumann, l’architettura che ha dominato l’informatica dagli anni Cinquanta. Brevemente, e senza entrare troppo nel dettaglio, in quel modello, memoria e processore sono entità separate e collegate da un collo di bottiglia che limita la velocità complessiva. I sistemi neuromorfici eliminano questa divisione, attraverso la fusione di calcolo e memoria in un unico flusso di elaborazione distribuita. I computer quantistici, invece, abbattono la sequenzialità stessa, operando in modo massivamente parallelo e probabilistico. Entrambe le tecnologie puntano ad un’informatica adattiva, capace di rispondere in tempo reale a input complessi;

non è solo una questione di potenza, ma di filosofia del calcolo: passare da macchine che eseguono a macchine che comprendono, che apprendono dal contesto e dall’incertezza.

È un cambio radicale di modus operandi, alla base di una nuova idea di intelligenza computazionale.

Prossimo capitolo? L’alba dell’informatica ibrida

Le frontiere non sono più rigide. Nei laboratori di ricerca, gli scienziati stanno già progettando architetture ibride che combinano processori classici, unità neuromorfiche e acceleratori quantistici. L’obiettivo è creare sistemi dove ogni componente svolge il ruolo per cui è più adatto: il processore classico per la logica deterministica, il chip neuromorfico per l’intelligenza sensoriale e il modulo quantistico per affrontare problemi di ottimizzazione e simulazione, un metodo che promette sia di moltiplicare la potenza di calcolo sia di ridurre drasticamente i consumi energetici ed i tempi di addestramento dei modelli di Intelligenza Artificiale. L’informatica ibrida è il punto di convergenza tra biologia, fisica e ingegneria, e nel prossimo decennio potremmo forse assistere alla nascita dei primi supercomputer ibridi in grado di combinare pensiero simbolico, intuizione e calcolo probabilistico. Una sintesi di mente e materia, di algoritmo e fisica, pronta a trasformare il significato stesso dell'Intelligenza Artificiale.

In conclusione...il futuro pensa diverso

Dal tubo catodico al qubit, l’informatica ha attraversato un secolo di trasformazioni, inseguendo sempre lo stesso sogno: creare macchine capaci di pensare. Il Novecento è stato il secolo del silicio, dominato dalla miniaturizzazione e dalla logica binaria, il XXI sarà quello dell’intelligenza fisica, un’informatica che nasce dalla materia, che apprende, evolve e calcola nell’incertezza. Un dato è più che certo, le macchine del futuro non si limiteranno a risolvere problemi, interpreteranno il mondo adattandosi ai contesti più disparati come fanno gli esseri viventi.

E forse, un giorno, guarderemo ai nostri laptop con la stessa nostalgia con cui oggi osserviamo l’ENIAC, ricordando con meraviglia l’epoca in cui tutto cominciò, con una valvola e un sogno di calcolo.

Riferimenti e Sitografia